多重比較問題

統計学における、多重比較、多重性、多重検定の問題は、複数の統計的推論を同時に検討したり[1]、観測値に基づいて選択されたパラメータのサブセットを推論したりするときに発生する[2]。

推論が多くなればなるほど、誤った推論の可能性が高くなる。この問題に対処するため、様々な統計的手法が開発されている。典型的な方法としては、行われる推論の数を補うように、個々の比較に対してより厳しい有意水準を要求する方法がある。

歴史

[編集]多重比較の問題は、1950年代にジョン・テューキーやヘンリー・シェッフェなどの統計学者の研究によって注目されるようになった。その後数十年にわたって、この問題に対処するために多くの手続きが開発された。1996年には、多重比較の取り扱いに関する最初の国際会議がテルアビブで開催された[3]。

定義

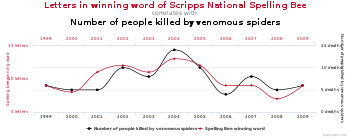

[編集]多重比較は、ある統計分析が複数の統計検定を同時に含み、その各々が何かしらの「発見」をもたらす可能性があるときに生じる。一般な分析の際には、個別の検定に信頼基準を設定し、設定された信頼基準は各々の検定にのみ適用されるが、多くの場合、同時に行われる検定の系列全体に対する一律の信頼水準を持つことが望ましい[4]。多重検定の補正に失敗すると、以下の例で示されるように、実際に重要な結果を招く可能性がある。

- 処置群は生徒に新しい方法でライティングを教えた群で、対照群は標準的なライティングの教え方を使った群だとする。2つのグループの生徒は、文法、スペル、構成、内容などの点で比較することができる。より多くの項目を比較すると、標本誤差だけで、少なくとも1つの項目で処置群と対照群が異なるように見える可能性が高くなる。

- ある薬の有効性を、いくつかの病気の症状のどれか1つの軽減という観点から考えるとする。より多くの症状を考慮すればするほど、少なくとも1つの症状において、その薬が既存の薬より改善されているように見える可能性が高くなる。

どちらの例でも、比較の数が増えるにつれて、比較されるグループが少なくとも1つの項目に関して異なって見える可能性が高くなる。ある結果が独立したデータによって一般化されるという確信は、一般的に、単一の比較のみを行った分析よりも、複数の比較を含む分析の一部として観察された場合の方が弱くなるはずである。

たとえば、1つの検定が有意水準5%で実施され、対応する帰無仮説が真であれば、帰無仮説を誤って棄却するリスクは5%だけである。しかし、100個の検定がそれぞれ有意水準5%で実施され、対応する帰無仮説がすべて真である場合、予想される不正確な棄却(偽陽性または第一種過誤としても知られる)の数は5つになる。また、検定が互いに統計的に独立している(すなわち、独立標本で実施されている)場合、誤った棄却が少なくとも1つある確率は約99.4%になる。

このような多重検定で発生する偽陽性率の上昇や網羅率の低下を防ぐ手法が開発されている。

多重仮説検定の分類

[編集]次の表は、複数の帰無仮説を検定するときに起こりうる結果を定義したものである。m個の帰無仮説があるとし、それぞれをH1, H2, ..., Hm.で表す。 統計的検定を用いて、検定が有意であると宣言された場合、帰無仮説を棄却する。検定が有意でない場合は、帰無仮説を棄却しない。すべてのHi にわたって各検定結果を合計すると、以下の確率変数が得られる。

| 帰無仮説が真であるケースの数 (H0) | 対立仮説が真であるケースの数 (HA) | 合計 | |

|---|---|---|---|

| 有意であるとされた検定の数 | V | S | R |

| 有意でないとされた検定の数 | U | T | |

| 合計 | m |

- m は検証された仮説の総数

- は、真の帰無仮説の数で、未知のパラメータ

- は、真の対立仮説の数

- V は、偽陽性(第一種過誤)の数(「偽の発見」とも呼ばれる)

- S は、真陽性の数(「真の発見」ともいう)

- T は、偽陰性(第二種過誤)の数

- U は、真陰性の数

- は、棄却された帰無仮説(「発見」とも呼ばれ、真または偽のいずれか)の数

m個の仮説検定のうち、 m_{0} は真の帰無仮説で、R は観察可能な確率変数、S, T, U, V は観察不可能な確率変数である。

制御手順

[編集]現在、技術上の問題で一時的にグラフが表示されなくなっています。 |

多重検定補正とは、多重検定の問題を解決するために統計的検定をより厳しくすることである。最もよく知られているのはボンフェローニ補正であるが、他の方法も開発されている。このような方法は通常、ファミリーワイズエラー率(FWER)または偽発見率(FDR)をコントロールするように設計されている。 m個の独立した比較が実行される場合、ファミリーワイズエラー率は次式で与えられる。

したがって、検定が完全に同一でない限り、は比較の数が増えるにつれて増加する。比較が独立であると仮定しない場合でも、ブールの不等式から、次の式が導ける。

例:

ファミリーワイズエラー率が最大でもであることを保証するさまざまな方法がある。最も保守的な方法は、従属性と分布の仮定が必要ない、ボンフェローニ補正()である。わずかに保守的でない補正として、個の独立比較の系列ごとの誤差率の式をについて解く方法がある。これによりという式が得られる。これはシダック補正として知られている。もう1つの手順はホルム=ボンフェローニ法で、これは最も厳密な基準に対して最も低いp値()のみを検定し、徐々に厳密でない基準に対してより高いp値()を検定することにより、単純なBonferroni補正よりも検出力を高くすることができる[5]()。

連続的な問題では、事前-事後の確率分布等からを計算するためにベイズ統計学の手法を採用することができる。ボンフェローニ補正とシダック補正の連続的な一般化は[6]に示されている。

大規模な多重検定

[編集]多重検定の調整のために考えられた伝統的な手法は、多くの場合、少数の多重比較の補正に焦点を当てている。数千またはそれ以上の数の検定が行われる大規模な多重検定については、異なる一連の手法が開発されてきた。例えば、ゲノミクスでは、マイクロアレイのような技術を用いると、何万もの遺伝子の発現レベルを測定することができ、何百万もの遺伝マーカーの遺伝子型を測定することができる。特に遺伝学的関連研究の分野では、ある研究では統計的に強く有意であったにもかかわらず、その後の研究で再現されないという、非再現性(non-replication)という深刻な問題がある。このような非再現性には多くの原因が考えられるが、多重比較の結果を十分に考慮していないことが原因の一つであると広く考えられている[7]。測定と情報技術の進歩により、探索的解析のための大規模なデータセットの作成がはるかに容易になり、多くの仮説が真であることを期待する事前の根拠がないまま、多くの仮説を検証することになることが多いと論じられている。このような状況では、多重比較調整を行わない限り、非常に高い偽陽性率が予想される。

断定的な結果を提供することが目的である大規模な検定問題では、統計的検定に有意水準を割り当てるためのパラメータとして、ファミリーワイズ誤差率が依然として最も受け入れられている。研究が探索的とみなされる場合や、有意な結果が独立した研究で簡単に再試験できる場合は、偽発見率(FDR)[8][9][10]による制御が好まれることが多い。FDRは、すべての有意な検定の中で予想される偽陽性の割合として緩やかに定義され、これを用いることで研究者は、フォローアップ研究でより厳密に評価するための「陽性候補」のセットを識別することができる[11]。

有意なものを見つけることを期待して多くの未調整の比較を試みる行為は、意図的であるかどうかによらず、「p-ハッキング」と呼ばれて問題視されている[12][13]。

関連項目

[編集]脚注

[編集]- ^ Miller, R.G. (1981). Simultaneous Statistical Inference 2nd Ed. Springer Verlag New York. ISBN 978-0-387-90548-8

- ^ Benjamini, Y. (2010). “Simultaneous and selective inference: Current successes and future challenges”. Biometrical Journal 52 (6): 708–721. doi:10.1002/bimj.200900299. PMID 21154895.

- ^ “Home”. mcp-conference.org. 2023年10月16日閲覧。

- ^ Kutner, Michael; Nachtsheim, Christopher; Neter, John; Li, William (2005). Applied Linear Statistical Models. McGraw-Hill Irwin. pp. 744–745. ISBN 9780072386882

- ^ Aickin, M; Gensler, H (May 1996). “Adjusting for multiple testing when reporting research results: the Bonferroni vs Holm methods”. Am J Public Health 86 (5): 726–728. doi:10.2105/ajph.86.5.726. PMC 1380484. PMID 8629727.

- ^ Bayer, Adrian E.; Seljak, Uroš (2020). “The look-elsewhere effect from a unified Bayesian and frequentist perspective”. Journal of Cosmology and Astroparticle Physics 2020 (10): 009. arXiv:2007.13821. Bibcode: 2020JCAP...10..009B. doi:10.1088/1475-7516/2020/10/009.

- ^ Qu, Hui-Qi; Tien, Matthew; Polychronakos, Constantin (2010-10-01). “Statistical significance in genetic association studies”. Clinical and Investigative Medicine 33 (5): E266–E270. ISSN 0147-958X. PMC 3270946. PMID 20926032.

- ^ Benjamini, Yoav; Hochberg, Yosef (1995). “Controlling the false discovery rate: a practical and powerful approach to multiple testing”. Journal of the Royal Statistical Society, Series B 57 (1): 125–133. JSTOR 2346101.

- ^ Storey, JD; Tibshirani, Robert (2003). “Statistical significance for genome-wide studies”. PNAS 100 (16): 9440–9445. Bibcode: 2003PNAS..100.9440S. doi:10.1073/pnas.1530509100. JSTOR 3144228. PMC 170937. PMID 12883005.

- ^ Efron, Bradley; Tibshirani, Robert; Storey, John D.; Tusher, Virginia (2001). “Empirical Bayes analysis of a microarray experiment”. Journal of the American Statistical Association 96 (456): 1151–1160. doi:10.1198/016214501753382129. JSTOR 3085878.

- ^ Noble, William S. (2009-12-01). “How does multiple testing correction work?” (英語). Nature Biotechnology 27 (12): 1135–1137. doi:10.1038/nbt1209-1135. ISSN 1087-0156. PMC 2907892. PMID 20010596.

- ^ Young, S. S., Karr, A. (2011). “Deming, data and observational studies”. Significance 8 (3): 116–120. doi:10.1111/j.1740-9713.2011.00506.x.

- ^ Smith, G. D., Shah, E. (2002). “Data dredging, bias, or confounding”. BMJ 325 (7378): 1437–1438. doi:10.1136/bmj.325.7378.1437. PMC 1124898. PMID 12493654.

参考文献

[編集]- F. Betz, T. Hothorn, P. Westfall (2010), Multiple Comparisons Using R, CRC Press

- S. Dudoit and M. J. van der Laan (2008), Multiple Testing Procedures with Application to Genomics, Springer

- Farcomeni, A. (2008). “A Review of Modern Multiple Hypothesis Testing, with particular attention to the false discovery proportion”. Statistical Methods in Medical Research 17 (4): 347–388. doi:10.1177/0962280206079046. hdl:11573/142139. PMID 17698936.

- Phipson, B.; Smyth, G. K. (2010). “Permutation P-values Should Never Be Zero: Calculating Exact P-values when Permutations are Randomly Drawn”. Statistical Applications in Genetics and Molecular Biology 9: Article39. arXiv:1603.05766. doi:10.2202/1544-6115.1585. PMID 21044043.

- P. H. Westfall and S. S. Young (1993), Resampling-based Multiple Testing: Examples and Methods for p-Value Adjustment, Wiley

- P. Westfall, R. Tobias, R. Wolfinger (2011) Multiple comparisons and multiple testing using SAS, 2nd edn, SAS Institute

- A gallery of examples of implausible correlations sourced by data dredging