|

この項目では、情報量(エントロピー)の概念の情報理論的側面について説明しています。熱力学的側面については「エントロピー」をご覧ください。

|

情報量(じょうほうりょう、エントロピーとも)は、情報理論の概念で、あるできごと(事象)が起きた際、それがどれほど起こりにくいかを表す尺度である。頻繁に起こるできごと(たとえば「犬が人を噛む」)が起こったことを知ってもそれはたいした「情報」にはならないが、逆に滅多に起こらないできごと(たとえば「人が犬を噛む」)が起これば、それはより多くの「情報」を含んでいると考えられる。情報量はそのできごとがどれだけの情報をもっているかの尺度であるともみなすことができる。

なおここでいう「情報」とは、あくまでそのできごとの起こりにくさ(確率)だけによって決まる純粋に数学的な量のことであり、それが個人・社会にとってどれだけ意義のあるものかとは無関係である。たとえば「自分が宝くじに当たった」事象と「見知らぬAさんが宝くじに当たった」事象は、前者の方が有意義な情報に見えるが、両者の情報量は全く同じである(宝くじが当たる確率は所与条件一定のもとでは誰でも同じであるから)。

選択情報量(自己エントロピー)と平均情報量(エントロピー)

それぞれのできごとの情報量だけでなく、それらのできごとの情報量の平均値を情報量と呼ぶ。両者を区別する場合には、前者を選択情報量(自己エントロピーとも)、後者を平均情報量(エントロピーとも)と呼ぶ。

選択情報量

事象 が起こる確率を

が起こる確率を とするとき、

事象

とするとき、

事象  が起こったことを知らされたとき受け取る(選択)情報量

が起こったことを知らされたとき受け取る(選択)情報量 を

を

と定義する。

起こりにくい事象(=生起確率が低い事象)の情報量ほど、値が大きい。

上式中の対数 ( ) の底として何を選んでも、情報量の値が定数倍変わるだけなので、本質的な差はないものの、底としては2を選ぶことが多い。

) の底として何を選んでも、情報量の値が定数倍変わるだけなので、本質的な差はないものの、底としては2を選ぶことが多い。

底が2の場合、 の確率で起こる事象の情報量は

の確率で起こる事象の情報量は である。

である。

直観的意味

整数 に対し、

に対し、 の対数

の対数 は

は 進法での

進法での の桁数にほぼ等しい値を表す。したがって、確率

の桁数にほぼ等しい値を表す。したがって、確率 で起こる事象の情報量は、ほぼ

で起こる事象の情報量は、ほぼ の桁数になる。

の桁数になる。

情報量の加法性

AとBが独立な事象のとき、「AもBも起こる」という事象の情報量は、Aの情報量とBの情報量の和である。

情報量には加法性がある。例えば、52枚のトランプから無作為に1枚を取り出すという試行を考える。「取り出したカードはハートの4である」という事象の情報量は、前述の定義からlog52 であると分かる。ここで、「取り出したカードのスートはハートである」という事象と「取り出したカードの数字は4である」という事象の二つを考えると、前者の情報量はlog4、後者はlog13 である。この両者の和はlog4 + log13 = log(4×13) = log52 となり、「取り出したカードはハートの4である」という事象の情報量と等しい。これは直感的要請に合致する。

平均情報量(エントロピー)

を、台が有限集合である確率空間とする。

を、台が有限集合である確率空間とする。 上の確率分布 Pが与えられたとき、各事象

上の確率分布 Pが与えられたとき、各事象 の選択情報量

の選択情報量 の期待値

の期待値

をPのエントロピーと呼ぶ(平均情報量、シャノン情報量、情報論のエントロピーとも)。

ただし、ここでP(A)=0のときは、 とみなす。これは

とみなす。これは であることによる。

であることによる。

また有限集合U上の値を取る確率変数Xが確率分布Pに従う場合には、XのエントロピーをH(X)=H(P)によって定める。すなわち、

。

。

エントロピーは常に非負の値(または無限大)を取る。

値x、yがそれぞれ確率変数X、Yに従う場合には、組 も確率変数とみなせる。この確率変数を

も確率変数とみなせる。この確率変数を と書くことにすると、確率変数

と書くことにすると、確率変数 のエントロピーは

のエントロピーは

になる。これを結合エントロピーと呼ぶ。

が互いに独立な確率変数である場合には、

が互いに独立な確率変数である場合には、 は

は に一致する。すなわち、全体の情報量

に一致する。すなわち、全体の情報量 は、それぞれの確率変数の情報量の和である。

は、それぞれの確率変数の情報量の和である。

しかし、XとYが互いに独立ではない場合は、 と

と は一致せず、前者より後者の方が大きい値になる。両者の情報量の差を相互情報量と呼び、

は一致せず、前者より後者の方が大きい値になる。両者の情報量の差を相互情報量と呼び、

で表す。相互情報量は常に非負の値になる。

事象Bが生じているという条件下における事象Aの条件付き情報量を によって定める。確率変数Xが与えられたとき、事象「

によって定める。確率変数Xが与えられたとき、事象「 」の条件付き情報量

」の条件付き情報量 のxに関する平均値を条件付きエントロピーといい、

のxに関する平均値を条件付きエントロピーといい、

で表す。

さらに確率変数Yが与えられたとき、事象「 」が生じているという条件下における事象「

」が生じているという条件下における事象「 」の条件付きエントロピー

」の条件付きエントロピー のyに関する平均値

のyに関する平均値

もやはり条件付きエントロピーと呼ぶ。

エントロピーの基本的性質

- 情報量は確率だけによって決まる。

- 情報量は非負の値または無限大を取る。

- nビットのビット列の空間(情報源)から(一様ランダムとは限らない方法で)ランダムにビット列を選んだときのエントロピーは、n以下になる。エントロピーがnになる必要十分条件は、ビット列が一様ランダムに選ばれることである。

- 確率変数XとYが独立である必要十分条件は、

が成立することである。

が成立することである。

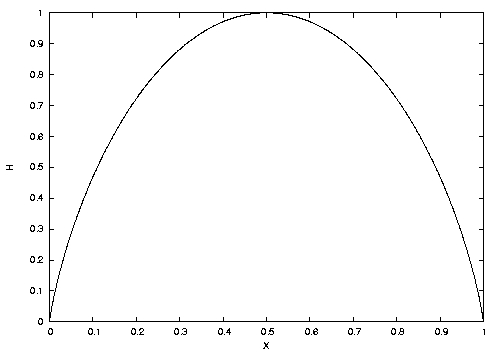

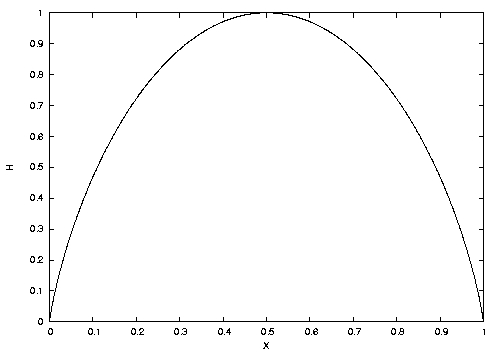

コイン投げの例

あるコインを投げたときに表が出る確率を  、裏が出る確率を

、裏が出る確率を  とする。このコインを投げたときに得られる平均情報量(エントロピー)は、

とする。このコインを投げたときに得られる平均情報量(エントロピー)は、

である。

この関数 をエントロピー関数と呼ぶ。

をエントロピー関数と呼ぶ。

図を見ると分かるように、 と

と  では

では  はゼロである。つまり、コインを投げる前から裏または表が出ることが確実に分かっているときに得られる平均情報量は、ゼロである。

はゼロである。つまり、コインを投げる前から裏または表が出ることが確実に分かっているときに得られる平均情報量は、ゼロである。 が最大になるのは

が最大になるのは  のときであり、一般にすべての事象(できごと)が等確率になるときにエントロピーが最大になる。

のときであり、一般にすべての事象(できごと)が等確率になるときにエントロピーが最大になる。

連続系のエントロピー

実数値を取る確率変数Xの確率密度関数をp(x)とするとき、Xのエントロピーを

によって定義する。

Xが有限集合に値を取る確率変数である場合には、Xのシャノン情報量 も定義できる。Xがn通りの値を取るとき、

も定義できる。Xがn通りの値を取るとき、 と

と は、

は、

を満たす。

ただし、ここで はn元集合上の一様分布とする(すなわち

はn元集合上の一様分布とする(すなわち )。

)。

Renyiエントロピー

を、台が有限集合である確率空間とする。Pを

を、台が有限集合である確率空間とする。Pを 上の確率分布とし、

上の確率分布とし、 を非負の実数とする。

を非負の実数とする。

のとき、Pのdegee

のとき、Pのdegee のRenyiエントロピーを

のRenyiエントロピーを

によって定義する。

また、 の場合には、Renyiエントロピーを

の場合には、Renyiエントロピーを

によって定義する。

単にRenyiエントロピーと言った場合は を意味することも多い。

を意味することも多い。

さらに、確率変数Xが確率分布Pに従うとき、 を

を によって定義する。

によって定義する。

Renyiエントロピーは以下の性質を満たす:

が成立する。

が成立する。 はシャノン情報量

はシャノン情報量  と一致する。

と一致する。 が2以上の整数の場合には、

が2以上の整数の場合には、  が成立する。ここで、

が成立する。ここで、  は確率分布

は確率分布  に従う独立同一分布であって、

に従う独立同一分布であって、  は

は  をそれぞれ

をそれぞれ に従って選んだときに

に従って選んだときに が成立する確率とする。

が成立する確率とする。 が成立する。この

が成立する。この  をminエントロピーともいう。

をminエントロピーともいう。

歴史

「エントロピー」の概念は1865年にルドルフ・クラウジウスがギリシャ語の「変換」を意味する言葉を語源として、熱力学における気体のある状態量として導入した。これは統計力学では微視的な状態数の対数に比例する量として表される。1929年にはレオ・シラードが、気体についての情報を観測者が獲得することと統計力学におけるエントロピーとの間に直接の関係があることを示し、現在 1 ビット(1 シャノン)と呼ぶ量が統計力学で k ln 2 に対応するという関係を導いていた[1]。

現在の情報理論におけるエントロピーの直接の導入は1948年のクロード・シャノンによるもので、その著書『通信の数学的理論』でエントロピーの概念を情報理論に応用した[2]。シャノン自身は統計力学でこの概念と関連する概念がすでに使われていることを知らずにこの定義に到達したが、その名称を考えていたとき同僚フォン・ノイマン(数学)が、統計力学のエントロピーに似ていることを指摘し「統計エントロピーが何なのかを理解してる人は少ないから議論になったときに君が有利であろう」と語ったことを受けて、シャノンはエントロピーと名付けた[3]。

なお、シャノン以前にもラルフ・ハートレーが1928年に、集合Aに対して という量を考察している(“

という量を考察している(“ ”はAの元数)。

”はAの元数)。 はA上の一様分布のエントロピーに一致する。

現在では、

はA上の一様分布のエントロピーに一致する。

現在では、 をAのハートレー・エントロピーと呼ぶ。

をAのハートレー・エントロピーと呼ぶ。

単位

情報量は本来無次元の量である。しかし、対数の底として何を用いたかによって値が異なるので,単位を付けて区別している。前述のように、情報量は確率の逆数の桁数の期待値なので、単位も桁数のそれを流用する。この為、対数の底として2、e、10を選んだときの情報量の単位は、それぞれビット(bit)、ナット(nat)、ディット(dit)である。

また、今のところ主流ではないものの、1997年に日本工業規格 JIS X 0016:1997(これは国際規格 ISO/IEC 2382-16:1996と一致している)は、これらの量を表す単位を別に定めている(ノートも参照)。

対数の底と単位

| 底 |

通常の単位 |

JISおよびISOが定めた単位 |

備考

|

| 2 |

ビット (bit) |

シャノン (shannon) |

lg

|

| e=2.718… |

ナット (nat) |

ナット (nat) |

ln, 自然対数

|

| 10 |

ディット (dit) |

ハートレー (hartley) |

log, 常用対数

|

単位「シャノン」、「ハートレー」の名称は、それぞれ情報量の概念を提案したクロード・シャノン、ラルフ・ハートレーにちなむ。

脚注

- ^ Szilard, L. (1929) "Über die Entropieverminderung in einem Thermodynamischen System bei Eingriffen Intelligenter Wesen", Zeitschrift für Physik 53:840–856

- ^ H・J・モロウィッツ『ピザの熱力学』

- ^ 韓太舜、小林欣吾『情報と符号の数理』

関連項目