「視覚と自然言語の融合研究」の版間の差分

Rrrwrrrrrw (会話 | 投稿記録) 不正確な用語の修正、出典の詳細の追加など タグ: 2017年版ソースエディター 曖昧さ回避ページへのリンク |

Rrrwrrrrrw (会話 | 投稿記録) 「背景」の作成、概要の追記、出典の追加など タグ: 2017年版ソースエディター |

||

| 1行目: | 1行目: | ||

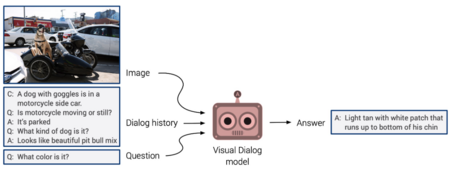

[[File:Vizwiz-vqa.png|thumb|300px|VQAの問題の例。]] |

[[File:Vizwiz-vqa.png|thumb|300px|VQAの問題の例。]] |

||

'''視覚と自然言語の融合研究'''{{Efn|日本語での表記は複数存在し、「視覚と自然言語の融合研究」<ref name=":0" />、「視覚と言語の融合研究」<ref>{{Cite web |title=NL研・CVIM研・PRMU研の合同研究会:第248回自然言語処理研究会 発表募集 |url=https://nl-ipsj.or.jp/2021/02/09/nl248-cfp/ |website=情報処理学会 自然言語処理研究会 (NL) |date=2021-02-09 |accessdate=2022-03-24 |language=ja }}</ref><ref>{{Cite web |title=【第48回AIセミナー】「マルチモーダル情報の統合理解の最前線」|url=https://www.airc.aist.go.jp/seminar_detail/seminar_048.html |publisher=人工知能研究センター |accessdate=2022-03-24}}</ref>、「画像と自然言語処理の融合研究」<ref name="ipa2017" />、「CVとNLPの融合研究」<ref name="ipsj-247nl" />などの他に"Vision and Language"と英語のままで呼ばれることもある<ref>{{Cite book2|title=コンピュータビジョン最前線 Winter 2021|year=2021|publisher=共立出版|page=78|editor2-first=祥孝|editor-last=井尻|editor-first=善久|editor2-last=牛久|editor3-first=裕雄|editor3-last=片岡|editor4-first=弘亘|editor4-last=藤吉}}</ref><ref>{{Cite journal|last=品川|first=政太朗|date=2021-05-13|title=Vision and Languageと分野を取り巻く深層学習手法の紹介|url=https://ipsj.ixsq.nii.ac.jp/ej/index.php?active_action=repository_view_main_item_detail&page_id=13&block_id=8&item_id=211162&item_no=1|journal=研究報告コンピュータビジョンとイメージメディア(CVIM)|volume=2021-CVIM-226|issue=15|pages=1–1|language=ja|issn=2188-8701}}</ref>。}}({{Lang-en|Vision and Language}}{{Efn|"Vision and Language"<ref>{{Cite web |title=Workshop on Vision and Language - ACL Anthology |url=https://aclanthology.org/venues/vl/ |website=ACL Anthology |accessdate=2022-03-24 |publisher=ACL}}</ref>{{Sfn|Mogadala|Kalimuthu|Klakow|2021}}<ref name=":1">{{Cite journal|last=Antol|first=Stanislaw|last2=Agrawal|first2=Aishwarya|last3=Lu|first3=Jiasen|last4=Mitchell|first4=Margaret|last5=Batra|first5=Dhruv|last6=Lawrence Zitnick|first6=C.|last7=Parikh|first7=Devi|date=2015|title=VQA: Visual Question Answering|url=https://www.cv-foundation.org/openaccess/content_iccv_2015/html/Antol_VQA_Visual_Question_ICCV_2015_paper.html|journal=Proceedings of the IEEE International Conference on Computer Vision (ICCV)|pages=2425–2433}}</ref>の他に"Language and Vision"<ref>{{Cite web |title=CVPR 2015 Language and Vision Workshop {{!}} The Center for Brains, Minds & Machines |url=https://cbmm.mit.edu/knowledge-transfer/workshops/cvpr-2015-language-and-vision-workshop |website= |accessdate=2022-03-24 |publisher=Center for Brain, Minds & Machines}}</ref>など表記に揺らぎはある。}})とは、[[コンピュータビジョン]]と[[自然言語処理]]を融合した研究分野である{{Sfn|Mogadala|Kalimuthu|Klakow|2021|p=1183}}<ref name="ipsj-247nl">{{Cite web |title=第247回NL研究発表会-情報処理学会 |url=https://www.ipsj.or.jp/kenkyukai/event/nl247.html |website=www.ipsj.or.jp |accessdate=2022-03-24 |language=ja |last=一般社団法人情報処理学会}}</ref>。画像や動画からのキャプション生成{{Refnest|<ref name=":0" /><ref name="ipa2017" />{{Sfn|Ferraro|2015|p=210}}}}、画像や動画を対象とした質問応答(VQA){{Refnest|<ref name=":0" /><ref name=":1" />{{Sfn|Ferraro|2015|p=210}}}}などが含まれる。 |

'''視覚と自然言語の融合研究'''{{Efn|日本語での表記は複数存在し、「視覚と自然言語の融合研究」<ref name=":0" />、「視覚と言語の融合研究」<ref>{{Cite web |title=NL研・CVIM研・PRMU研の合同研究会:第248回自然言語処理研究会 発表募集 |url=https://nl-ipsj.or.jp/2021/02/09/nl248-cfp/ |website=情報処理学会 自然言語処理研究会 (NL) |date=2021-02-09 |accessdate=2022-03-24 |language=ja }}</ref><ref>{{Cite web |title=【第48回AIセミナー】「マルチモーダル情報の統合理解の最前線」|url=https://www.airc.aist.go.jp/seminar_detail/seminar_048.html |publisher=人工知能研究センター |accessdate=2022-03-24}}</ref>、「画像と自然言語処理の融合研究」<ref name="ipa2017" />、「CVとNLPの融合研究」<ref name="ipsj-247nl" />などの他に"Vision and Language"と英語のままで呼ばれることもある<ref>{{Cite book2|title=コンピュータビジョン最前線 Winter 2021|year=2021|publisher=共立出版|page=78|editor2-first=祥孝|editor-last=井尻|editor-first=善久|editor2-last=牛久|editor3-first=裕雄|editor3-last=片岡|editor4-first=弘亘|editor4-last=藤吉}}</ref><ref>{{Cite journal|last=品川|first=政太朗|date=2021-05-13|title=Vision and Languageと分野を取り巻く深層学習手法の紹介|url=https://ipsj.ixsq.nii.ac.jp/ej/index.php?active_action=repository_view_main_item_detail&page_id=13&block_id=8&item_id=211162&item_no=1|journal=研究報告コンピュータビジョンとイメージメディア(CVIM)|volume=2021-CVIM-226|issue=15|pages=1–1|language=ja|issn=2188-8701}}</ref>。}}({{Lang-en|Vision and Language}}{{Efn|"Vision and Language"<ref>{{Cite web |title=Workshop on Vision and Language - ACL Anthology |url=https://aclanthology.org/venues/vl/ |website=ACL Anthology |accessdate=2022-03-24 |publisher=ACL}}</ref>{{Sfn|Mogadala|Kalimuthu|Klakow|2021}}<ref name=":1">{{Cite journal|last=Antol|first=Stanislaw|last2=Agrawal|first2=Aishwarya|last3=Lu|first3=Jiasen|last4=Mitchell|first4=Margaret|last5=Batra|first5=Dhruv|last6=Lawrence Zitnick|first6=C.|last7=Parikh|first7=Devi|date=2015|title=VQA: Visual Question Answering|url=https://www.cv-foundation.org/openaccess/content_iccv_2015/html/Antol_VQA_Visual_Question_ICCV_2015_paper.html|journal=Proceedings of the IEEE International Conference on Computer Vision (ICCV)|pages=2425–2433}}</ref>の他に"Language and Vision"<ref>{{Cite web |title=CVPR 2015 Language and Vision Workshop {{!}} The Center for Brains, Minds & Machines |url=https://cbmm.mit.edu/knowledge-transfer/workshops/cvpr-2015-language-and-vision-workshop |website= |accessdate=2022-03-24 |publisher=Center for Brain, Minds & Machines}}</ref>など表記に揺らぎはある。}})とは、[[コンピュータビジョン]]と[[自然言語処理]]を融合した研究分野である{{Sfn|Mogadala|Kalimuthu|Klakow|2021|p=1183}}<ref name="ipsj-247nl">{{Cite web |title=第247回NL研究発表会-情報処理学会 |url=https://www.ipsj.or.jp/kenkyukai/event/nl247.html |website=www.ipsj.or.jp |accessdate=2022-03-24 |language=ja |last=一般社団法人情報処理学会}}</ref>。画像や動画からのキャプション生成{{Refnest|<ref name=":0" /><ref name="ipa2017" />{{Sfn|Ferraro|2015|p=210}}}}、画像や動画を対象とした質問応答(VQA){{Refnest|<ref name=":0" /><ref name=":1" />{{Sfn|Ferraro|2015|p=210}}}}などのタスクが含まれる。 |

||

1960年代から初期の研究が始められており{{Sfn|Ferraro|2015|p=207}}<ref name=":4" />、2010年代に[[ディープラーニング|深層学習]]の適用によって[[コンピュータビジョン]]と[[自然言語処理]]が大きく発展したことに伴い、融合研究も発展を遂げている{{Sfn|Ferraro|2015|p=207}}{{Sfn|Kafle|2019|loc=1. Introduction}}。 |

1960年代から初期の研究が始められており{{Sfn|Ferraro|2015|p=207}}<ref name=":4" />、1990年代ごろから画像検索{{Sfn|Kafle|2019|loc=2.1. Tasks in V&L Research}}、2000年代から画像キャプション生成{{Sfn|Wang|2021|p=2}}の研究も始められた。2010年代に[[ディープラーニング|深層学習]]の適用によって[[コンピュータビジョン]]と[[自然言語処理]]が大きく発展したことに伴い、融合研究も発展を遂げている{{Sfn|Ferraro|2015|p=207}}{{Sfn|Kafle|2019|loc=1. Introduction}}。発展をする一方で、データセットバイアスなどの研究課題も残されている{{Sfn|Kafle|2019|loc=3.1. Dataset Bias}}{{Sfn|Kafle|2019|loc=3.2. Evaluation Metrics}}。 |

||

== 背景 == |

|||

視覚と自然言語の融合研究は、[[コンピュータビジョン]]と[[自然言語処理]]を融合した研究分野である{{Sfn|Mogadala|Kalimuthu|Klakow|2021|p=1183}}<ref name="ipsj-247nl" />。2つの分野は独立して研究されてきたが、[[ヒューマンコンピュータインタラクション]]や[[視覚障害者]]の支援といった応用が期待されることもあり、融合研究が注目されるようになった{{Sfn|Mogadala|Kalimuthu|Klakow|2021|pp=1183-1184}}{{Sfn|Kafle|2019|loc=1. Introduction}}。 |

|||

=== コンピュータビジョン === |

|||

{{Main|コンピュータビジョン}} |

|||

コンピュータビジョンは、[[コンピュータ]]に[[画像]]や[[動画]]の内容を理解させる分野である{{Sfn|Sonka|2008|p=1}}<ref>{{Cite journal|last=Huang|first=T|date=1996|title=Computer Vision: Evolution And Promise|url=http://cds.cern.ch/record/400313|language=en|doi=10.5170/CERN-1996-008.21}}</ref><ref>{{Cite web |title=コンピューター ビジョンとは {{!}} Microsoft Azure |url=https://azure.microsoft.com/ja-jp/overview/what-is-computer-vision/ |accessdate=2022-04-08 |language=ja |publisher=Microsoft}}</ref>。主なタスクとしては画像[[分類 (統計学)|分類]]{{Sfn|Mogadala|Kalimuthu|Klakow|2021|p=1185}}や[[物体検出]]{{Sfn|Sonka|2008|p=385}}{{Sfn|Mogadala|Kalimuthu|Klakow|2021|p=1185}}などが含まれる。[[敵対的生成ネットワーク]]などによる画像生成が含まれる場合もある<ref>{{Cite journal|last=Cao|first=Yang-Jie|last2=Jia|first2=Li-Li|last3=Chen|first3=Yong-Xia|last4=Lin|first4=Nan|last5=Yang|first5=Cong|last6=Zhang|first6=Bo|last7=Liu|first7=Zhi|last8=Li|first8=Xue-Xiang|last9=Dai|first9=Hong-Hua|date=2019|title=Recent Advances of Generative Adversarial Networks in Computer Vision|url=https://ieeexplore.ieee.org/document/8576508/|journal=IEEE Access|volume=7|pages=14985–15006|doi=10.1109/ACCESS.2018.2886814|issn=2169-3536}}</ref><ref>{{Cite journal|last=Wang|first=Zhengwei|last2=She|first2=Qi|last3=Ward|first3=Tomás E.|date=2022-03-31|title=Generative Adversarial Networks in Computer Vision: A Survey and Taxonomy|url=https://dl.acm.org/doi/10.1145/3439723|journal=ACM Computing Surveys|volume=54|issue=2|pages=1–38|language=en|doi=10.1145/3439723|issn=0360-0300}}</ref>。 |

|||

=== 自然言語処理 === |

|||

{{Main|自然言語処理}} |

|||

自然言語処理は、人間が使用する言語([[自然言語]])をコンピュータに処理させる分野である{{Sfn|Jurafsky|2009|p=1}}{{Sfn|Eisenstein|2019|p=1}}。主なタスクとしては[[情報検索]]{{Sfn|Jurafsky|2009|p=737}}{{Sfn|Eisenstein|2019|p=424}}、[[質問応答システム|質問応答]]{{Sfn|Jurafsky|2009|p=1}}{{Sfn|Eisenstein|2019|p=424}}、[[機械翻訳]]{{Sfn|Jurafsky|2009|p=1}}{{Sfn|Eisenstein|2019|p=431}}などが含まれる。 |

|||

== 主な研究分野 == |

== 主な研究分野 == |

||

| 15行目: | 27行目: | ||

; 画像・動画への質問応答(Visual Question Answering、VQA) |

; 画像・動画への質問応答(Visual Question Answering、VQA) |

||

: 自然言語処理における質問応答タスクを拡張した、画像や動画に関する質問に答えるタスクである{{Sfn|Mogadala|Kalimuthu|Klakow|2021|p=1187}}。 |

: 自然言語処理における[[質問応答システム|質問応答]]は、人間の質問に対して回答するタスクである{{Sfn|Jurafsky|2009|p=779}}。質問応答では、質問に回答するにあたって必要な情報を得るために、なんらかの文書を参照する場合もある{{Sfn|Jurafsky|2009|p=780}}。質問応答が自然言語のみを使用するのに対して、VQAは質問応答タスクを拡張した、画像や動画に関する質問に答えるタスクである{{Sfn|Mogadala|Kalimuthu|Klakow|2021|p=1187}}。 |

||

: 未知の物体にも対応するようなVQAは2014年に研究が始められた{{Sfn|Wu|2017|p=3}}。 |

: 未知の物体にも対応するようなVQAは2014年に研究が始められた{{Sfn|Wu|2017|p=3}}。 |

||

| 232行目: | 244行目: | ||

=== データセットバイアス === |

=== データセットバイアス === |

||

データセットバイアスとは、機械学習モデルの学習に使用したときに誤った結論を導く可能性がある、データセットの偏りのことである<ref>{{Citation|title=Domain Adaptation in Computer Vision Applications|last=Tommasi|first=Tatiana|last2=Patricia|first2=Novi|last3=Caputo|first3=Barbara|last4=Tuytelaars|first4=Tinne|date=2017|year=2017|url=https://doi.org/10.1007/978-3-319-58347-1_2|publisher=Springer International Publishing|editor-last=Csurka|editor-first=Gabriela|page=39|chapter=A Deeper Look at Dataset Bias|isbn=978-3-319-58347-1|language=en|doi=10.1007/978-3-319-58347-1_2}}</ref>。例えば、画像データセットを用いて「[[自動車]]」を認識する機械学習モデルを学習するときに、「[[ImageNet]]」というデータセットでは「自動車」というラベルに[[スポーツカー]]を多く含むため、[[自家用自動車|自家用車]]の検出性能が低くなってしまうという問題が起こることがある<ref>{{Cite journal|last=Torralba|first=Antonio|last2=Efros|first2=Alexei A.|date=2011-06|title=Unbiased look at dataset bias|url=https://ieeexplore.ieee.org/document/5995347|journal=CVPR 2011|pages=1521–1528|doi=10.1109/CVPR.2011.5995347}}</ref>。逆に、学習データとテストデータは多くの場合は同じ条件で集められているため、学習データを記憶するだけでテストデータにも対応できてしまい、実際の性能よりも高く評価されてしまうという問題が起こることもある{{Sfn|Kafle|2019|loc=3.1. Dataset Bias}}。 |

データセットバイアスとは、機械学習モデルの学習に使用したときに誤った結論を導く可能性がある、[[データセット]]の偏りのことである<ref>{{Citation|title=Domain Adaptation in Computer Vision Applications|last=Tommasi|first=Tatiana|last2=Patricia|first2=Novi|last3=Caputo|first3=Barbara|last4=Tuytelaars|first4=Tinne|date=2017|year=2017|url=https://doi.org/10.1007/978-3-319-58347-1_2|publisher=Springer International Publishing|editor-last=Csurka|editor-first=Gabriela|page=39|chapter=A Deeper Look at Dataset Bias|isbn=978-3-319-58347-1|language=en|doi=10.1007/978-3-319-58347-1_2}}</ref>。例えば、画像データセットを用いて「[[自動車]]」を認識する機械学習モデルを学習するときに、「[[ImageNet]]」というデータセットでは「自動車」というラベルに[[スポーツカー]]を多く含むため、[[自家用自動車|自家用車]]の検出性能が低くなってしまうという問題が起こることがある<ref>{{Cite journal|last=Torralba|first=Antonio|last2=Efros|first2=Alexei A.|date=2011-06|title=Unbiased look at dataset bias|url=https://ieeexplore.ieee.org/document/5995347|journal=CVPR 2011|pages=1521–1528|doi=10.1109/CVPR.2011.5995347}}</ref>。逆に、学習データとテストデータは多くの場合は同じ条件で集められているため、学習データを記憶するだけでテストデータにも対応できてしまい、実際の性能よりも高く評価されてしまうという問題が起こることもある{{Sfn|Kafle|2019|loc=3.1. Dataset Bias}}。 |

||

データセットバイアスはコンピュータビジョンや自然言語処理のそれぞれの分野でも問題となるが、両方の分野を対象とする融合研究ではより深刻な影響を受けるとされている{{Sfn|Kafle|2019|loc=3.1. Dataset Bias}}。一例として、VQAのデータセットにおいて、質問に対する回答に偏りがあると画像を使わなくても一定の精度を達成できてしまうことが知られている{{Sfn|Kafle|2019|loc=3.1. Dataset Bias}}。例えばデータセットに「画像中に〜がありますか」という形式の質問が複数あり、答えとして「はい」が多いという偏りがあるとする{{Sfn|Kafle|2019|loc=3.1. Dataset Bias}}。機械学習モデルは画像の内容を確認して答えることが期待されるが、自然言語の質問だけを見て「画像中に〜がありますか」という形式の質問には常に「はい」と答えるように学習をされてしまうことが起こり得る{{Sfn|Kafle|2019|loc=3.1. Dataset Bias}}。 |

データセットバイアスはコンピュータビジョンや自然言語処理のそれぞれの分野でも問題となるが、両方の分野を対象とする融合研究ではより深刻な影響を受けるとされている{{Sfn|Kafle|2019|loc=3.1. Dataset Bias}}<ref>{{Cite web |url=https://web.stanford.edu/class/archive/cs/cs224n/cs224n.1194/slides/cs224n-2019-lecture19-bias.pdf |title=Bias in the Vision and Language of Artificial Intelligence |accessdate=2022-04-08 |author=Margaret Mitchell}}</ref>。一例として、VQAのデータセットにおいて、質問に対する回答に偏りがあると画像を使わなくても一定の精度を達成できてしまうことが知られている{{Sfn|Kafle|2019|loc=3.1. Dataset Bias}}<ref name=":1">{{Cite journal|last=Antol|first=Stanislaw|last2=Agrawal|first2=Aishwarya|last3=Lu|first3=Jiasen|last4=Mitchell|first4=Margaret|last5=Batra|first5=Dhruv|last6=Zitnick|first6=C. Lawrence|last7=Parikh|first7=Devi|date=2015-12|title=VQA: Visual Question Answering|url=http://ieeexplore.ieee.org/document/7410636/|journal=2015 IEEE International Conference on Computer Vision (ICCV)|pages=2425–2433|publisher=IEEE|location=Santiago, Chile|doi=10.1109/ICCV.2015.279|isbn=978-1-4673-8391-2}}</ref>。例えばデータセットに「画像中に〜がありますか」という形式の質問が複数あり、答えとして「はい」が多いという偏りがあるとする{{Sfn|Kafle|2019|loc=3.1. Dataset Bias}}。機械学習モデルは画像の内容を確認して答えることが期待されるが、自然言語の質問だけを見て「画像中に〜がありますか」という形式の質問には常に「はい」と答えるように学習をされてしまうことが起こり得る{{Sfn|Kafle|2019|loc=3.1. Dataset Bias}}<ref name=":1" />。 |

||

解決方法としてデータセットからバイアスを取り除く方法が研究されているが、大規模なデータセットにおいてあらゆる要素のバイアスを取り除くことは不可能に近く、未解決の問題とされている{{Sfn|Kafle|2019|loc=3.1. Dataset Bias}}。 |

解決方法としてデータセットからバイアスを取り除く方法が研究されているが、大規模なデータセットにおいてあらゆる要素のバイアスを取り除くことは不可能に近く、未解決の問題とされている{{Sfn|Kafle|2019|loc=3.1. Dataset Bias}}。 |

||

=== 評価の難しさ === |

=== 評価の難しさ === |

||

評価手法はコンピュータビジョンと自然言語処理の各分野においても課題のひとつであるが、融合研究においてはさらに大きな問題となっているとされている{{Sfn|Kafle|2019|loc=3.2. Evaluation Metrics}}。特に自然言語 |

評価手法はコンピュータビジョンと自然言語処理の各分野においても課題のひとつであるが、融合研究においてはさらに大きな問題となっているとされている{{Sfn|Kafle|2019|loc=3.2. Evaluation Metrics}}。特に自然言語生成に関係するタスクにおける評価は難しいとされる{{Sfn|Kafle|2019|loc=3.2. Evaluation Metrics}}{{Sfn|Iqbal|2020|p=12}}<ref>{{Cite journal|last=Novikova|first=Jekaterina|last2=Dušek|first2=Ondřej|last3=Cercas Curry|first3=Amanda|last4=Rieser|first4=Verena|date=2017|title=Why We Need New Evaluation Metrics for NLG|url=http://aclweb.org/anthology/D17-1238|journal=Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing|pages=2241–2252|publisher=Association for Computational Linguistics|location=Copenhagen, Denmark|language=en|doi=10.18653/v1/D17-1238}}</ref>。例えば画像キャプション生成において「男性が木の横を歩いている」と「男が木のそばを散歩している」という二つの文章はほとんど同じ意味を表しているが、自動的に類似度の評価を行うことは難しい{{Sfn|Kafle|2019|loc=3.2. Evaluation Metrics}}。また、VQAにおいて「[[鳥類|鳥]]」という答えが正解とされている問題に対して、「[[鷹]]」という答えが正しいのかどうかを自動的に評価することは難しい{{Sfn|Kafle|2019|loc=3.2. Evaluation Metrics}}。 |

||

評価手法を改善する研究は行われているが、未解決の問題となっている{{Sfn|Kafle|2019|loc=3.2. Evaluation Metrics}}。 |

評価手法を改善する研究は行われているが、未解決の問題となっている{{Sfn|Kafle|2019|loc=3.2. Evaluation Metrics}}。 |

||

| 254行目: | 266行目: | ||

=== 書籍 === |

=== 書籍 === |

||

* {{Cite book|洋書|title=Deep Learning|url=https://mitpress.mit.edu/books/deep-learning|publisher=MIT Press|date=2016-11-18|location=Cambridge, MA, USA|isbn=978-0-262-03561-3|language=en|first=Ian|last=Goodfellow|first2=Yoshua|last2=Bengio|first3=Aaron|last3=Courville|ref={{SfnRef|Goodfellow|2016}}}} |

* {{Cite book|洋書|title=Deep Learning|url=https://mitpress.mit.edu/books/deep-learning|publisher=MIT Press|date=2016-11-18|location=Cambridge, MA, USA|isbn=978-0-262-03561-3|language=en|first=Ian|last=Goodfellow|first2=Yoshua|last2=Bengio|first3=Aaron|last3=Courville|ref={{SfnRef|Goodfellow|2016}}}} |

||

* {{cite book|洋書|author1=Milan Sonka|author2=Vaclav Hlavac|author3=Roger Boyle|title=Image Processing, Analysis, and Machine Vision|publisher=Thomson|year=2008|isbn=978-0-495-08252-1|ref={{SfnRef|Sonka|2008}}}} |

|||

* {{Cite book|洋書|edition=Second edition|title=Speech and language processing : an introduction to natural language processing, computational linguistics, and speech recognition|url=https://www.worldcat.org/oclc/213375806|isbn=978-0-13-187321-6|oclc=213375806|first=Daniel|last=Jurafsky|year=2009|publisher=Prentice Hall|ref={{SfnRef|Jurafsky|2009}}|first2=James H.|last2=Martin}} |

|||

* {{Cite book|洋書|title=Introduction to natural language processing|url=https://www.worldcat.org/oclc/1080249173|location=Cambridge, Massachusetts|isbn=978-0-262-04284-0|oclc=1080249173|first=Jacob|last=Eisenstein|year=2019|publisher=The MIT Press|ref={{SfnRef|Eisenstein|2019}}}} |

|||

=== サーベイ論文(視覚と自然言語の融合研究について) === |

=== サーベイ論文(視覚と自然言語の融合研究について) === |

||

| 285行目: | 299行目: | ||

* {{Cite journal|last=Khan|first=Salman|last2=Naseer|first2=Muzammal|last3=Hayat|first3=Munawar|last4=Zamir|first4=Syed Waqas|last5=Khan|first5=Fahad Shahbaz|last6=Shah|first6=Mubarak|date=2021-12-07|title=Transformers in Vision: A Survey|url=https://doi.org/10.1145/3505244|journal=ACM Computing Surveys|ref={{SfnRef|Khan|2021}}|doi=10.1145/3505244|issn=0360-0300}} |

* {{Cite journal|last=Khan|first=Salman|last2=Naseer|first2=Muzammal|last3=Hayat|first3=Munawar|last4=Zamir|first4=Syed Waqas|last5=Khan|first5=Fahad Shahbaz|last6=Shah|first6=Mubarak|date=2021-12-07|title=Transformers in Vision: A Survey|url=https://doi.org/10.1145/3505244|journal=ACM Computing Surveys|ref={{SfnRef|Khan|2021}}|doi=10.1145/3505244|issn=0360-0300}} |

||

* {{Cite journal|last=Han|first=Kai|last2=Wang|first2=Yunhe|last3=Chen|first3=Hanting|last4=Chen|first4=Xinghao|last5=Guo|first5=Jianyuan|last6=Liu|first6=Zhenhua|last7=Tang|first7=Yehui|last8=Xiao|first8=An|last9=Xu|first9=Chunjing|date=2022|title=A Survey on Vision Transformer|url=https://ieeexplore.ieee.org/document/9716741/|journal=IEEE Transactions on Pattern Analysis and Machine Intelligence|ref={{SfnRef|Han|2022}}|doi=10.1109/TPAMI.2022.3152247|issn=0162-8828}} |

* {{Cite journal|last=Han|first=Kai|last2=Wang|first2=Yunhe|last3=Chen|first3=Hanting|last4=Chen|first4=Xinghao|last5=Guo|first5=Jianyuan|last6=Liu|first6=Zhenhua|last7=Tang|first7=Yehui|last8=Xiao|first8=An|last9=Xu|first9=Chunjing|date=2022|title=A Survey on Vision Transformer|url=https://ieeexplore.ieee.org/document/9716741/|journal=IEEE Transactions on Pattern Analysis and Machine Intelligence|ref={{SfnRef|Han|2022}}|doi=10.1109/TPAMI.2022.3152247|issn=0162-8828}} |

||

* {{Cite journal|last=Iqbal|first=Touseef|last2=Qureshi|first2=Shaima|date=2020-04-13|title=The survey: Text generation models in deep learning|url=https://www.sciencedirect.com/science/article/pii/S1319157820303360|journal=Journal of King Saud University - Computer and Information Sciences|language=en|ref={{SfnRef|Iqbal|2020}}|doi=10.1016/j.jksuci.2020.04.001|issn=1319-1578}} |

|||

{{DEFAULTSORT:しかくとしぜんげんごのゆうごうけんきゅう}} |

{{DEFAULTSORT:しかくとしぜんげんごのゆうごうけんきゅう}} |

||

2022年4月8日 (金) 18:26時点における版

視覚と自然言語の融合研究[注釈 1](英語: Vision and Language[注釈 2])とは、コンピュータビジョンと自然言語処理を融合した研究分野である[12][5]。画像や動画からのキャプション生成[14]、画像や動画を対象とした質問応答(VQA)[15]などのタスクが含まれる。

1960年代から初期の研究が始められており[16][17]、1990年代ごろから画像検索[18]、2000年代から画像キャプション生成[19]の研究も始められた。2010年代に深層学習の適用によってコンピュータビジョンと自然言語処理が大きく発展したことに伴い、融合研究も発展を遂げている[16][20]。発展をする一方で、データセットバイアスなどの研究課題も残されている[21][22]。

背景

視覚と自然言語の融合研究は、コンピュータビジョンと自然言語処理を融合した研究分野である[12][5]。2つの分野は独立して研究されてきたが、ヒューマンコンピュータインタラクションや視覚障害者の支援といった応用が期待されることもあり、融合研究が注目されるようになった[23][20]。

コンピュータビジョン

コンピュータビジョンは、コンピュータに画像や動画の内容を理解させる分野である[24][25][26]。主なタスクとしては画像分類[27]や物体検出[28][27]などが含まれる。敵対的生成ネットワークなどによる画像生成が含まれる場合もある[29][30]。

自然言語処理

自然言語処理は、人間が使用する言語(自然言語)をコンピュータに処理させる分野である[31][32]。主なタスクとしては情報検索[33][34]、質問応答[31][34]、機械翻訳[31][35]などが含まれる。

主な研究分野

視覚と自然言語の融合研究として以下のような分野が研究されている[36][18][1][4]。

自然言語処理のタスクの拡張

- 画像・動画の説明生成

- 画像や動画に対する説明を生成するタスクである[36][注釈 3]。この融合分野の代表的なタスクとされる[37]画像キャプション生成も含まれる[38]。

- 画像キャプション生成の研究は2000年代から行われている[19]。

- 画像・動画への質問応答(Visual Question Answering、VQA)

- 自然言語処理における質問応答は、人間の質問に対して回答するタスクである[39]。質問応答では、質問に回答するにあたって必要な情報を得るために、なんらかの文書を参照する場合もある[40]。質問応答が自然言語のみを使用するのに対して、VQAは質問応答タスクを拡張した、画像や動画に関する質問に答えるタスクである[36]。

- 未知の物体にも対応するようなVQAは2014年に研究が始められた[41]。

- 画像検索(Image Retrieval)

- 多数の画像の中から、画像を検索するタスクである[42]。キーワードや文章などの自然言語をクエリとして使用するタスク、画像をクエリとして類似している画像を検索するタスク、手書きの絵をクエリとするタスクなどが研究されている[43][44]。

- 従来は画像に人間がつけたキャプションなどを利用して検索を行っていたが、1990年代から画像に含まれる視覚情報も用いて検索を行う研究が行われるようになった[45][42]。

- 画像・動画に関する対話(Visual Dialog)

- 画像や動画に含まれる情報に対して、自然言語を用いて対話を行うタスクである[36]。例えば、人間が対話システムに画像の内容に関する複数の質問を問いかけるという対話において、対話システムは過去の対話内容も考慮して回答する必要がある[46]。

- Visual Dialogは2017年に提案されて研究が始まった[47]。

- 画像の参照表現(Visual Referring Expression)の理解・生成

- 参照表現(Referring Expression)とは「左の三つの玉のうちの一番右の玉」のように複数の物体の中から特定の物体を識別するための言語表現である[48]。視覚との融合分野では、自然言語で与えられた参照表現に対応する物体を画像中で示したり、画像中の物体に対応する参照表現を生成するタスクが研究されている[49]。

- 参照表現生成の研究は自然言語処理の分野で1970年代から行われているが[50]、2010年代まで画像などに含まれる視覚情報を直接使うような手法はほとんど研究されていなかった[51][52]。深層学習を用いた画像の参照表現の理解と生成の最初の研究は2016年に発表され[53]、画像から直接の参照表現の理解・生成を行う研究が始まった[52]。

- 画像の含意関係認識(Visual Entailment)

- 自然言語処理において、含意関係認識という「ある文章が正しければもう一方の文章も正しいと言えるか」を判別するタスクがある[36]。例えば「川端康成は「雪国」などの作品でノーベル文学賞を受賞した」という文章が正しいときは「川端康成は「雪国」の作者である」も正しいという関係を判別することが求められる[54]。視覚との融合分野では、画像に示された状況が正しいときに与えられた文章が正しいと言えるかを判別するタスクが提案されている[36]。

- 2018年にVisual Entailmentのタスクを提案する研究が発表された[55]。

コンピュータビジョンのタスクの拡張

- 文章に対する画像生成

- 与えられた文章に対応した画像を生成するタスクである[36][注釈 4]。

- 敵対的生成ネットワーク(GAN)の登場に伴い、2016年に文章から画像を生成する最初の研究が発表された[60]。

- Visual Reasoning

- 画像分類や物体検出を拡張したタスクであり[36]、画像や動画に含まれる視覚情報を理解するタスクである[61]。一例として、画像に含まれる複数の物体同士の関係性などを理解するタスクなどが含まれる[62][63]。Visual Reasoningは視覚情報に対する質問に回答するための過程として定義されることもある[64]。すなわち、VQAやVisual Dialogのモデルは(明示的に設計されていなくても)Visual Reasoningを行なっていることになる[64]。Visual Reasoningの手法を評価するために、VQAを用いることも一般的である[63]。

- 初期の研究は1960年代から行われている[62]。

自然言語処理とコンピュータビジョンのタスクの拡張

- 視覚と言語を用いたナビゲーション

- ナビゲーションはロボットなどに対して目的地までの道順を案内するタスクであり[65]、視覚情報もしくは自然言語のみでのナビゲーションが研究されてきた[36]。これらを拡張して、視覚と自然言語の両方の情報を使用するタスクが融合分野として研究されている[36]。

- 視覚と自然言語の両方の情報を用いるナビゲーションとしては、最初のデータセットが2017年に発表されている[66]。

歴史

黎明期(1960年代以降)

1968年から始められたSHRDLUというプロジェクトが、視覚と自然言語の融合における最初期の研究のひとつとされている[16][17]。SHRDLUは人間が自然言語で指示をすることで、コンピュータ内の仮想空間の積み木を操作できるコンピュータプログラムである[17]。これ以降の視覚と自然言語の融合研究では、ロボットを自然言語による対話で操作するという分野が多く研究されてきた[16]。

深層学習以前(1990年代〜2000年代)

画像検索も視覚と自然言語の融合研究における最初期のタスクのひとつである[18]。従来は画像に人間がつけたキャプションを利用していたが、1990年代から画像の視覚情報も用いて検索を行う研究が行われるようになった[42][67]。

画像キャプション生成は2000年代ごろから研究が行われており、主にテンプレートを用いた手法が提案されていた[19]。テンプレートを用いて文章を生成するためにSIFTやHOGなどの局所画像特徴量[68]に対してサポートベクターマシン(SVM)などの分類器を適用するなどの手法が提案された[69][70]。

深層学習の適用(2010年代以降)

2010年代の深層学習の適用によって、画像と自然言語処理の融合分野も大きな発展を遂げた[16][20]。VQA(2014年)[注釈 5]、マルチモーダル機械翻訳(2016年)[56]、Visual Dialog(2017年)[47]、視覚と言語を用いたナビゲーション(2017年)[66]といったタスクの研究も2010年代に始まった。

深層学習が適用されるようになってからは、主に畳み込みニューラルネットワーク(CNN)を用いて画像や動画の特徴量を、回帰型ニューラルネットワーク(RNN)を用いて自然言語の特徴量を抽出して、2種類の特徴量を統合する手法が研究されてきた[71]。2019年からはTransformer[72][73]という共通のモデルを用いる手法が研究されている[74][75]。

手法

視覚情報と自然言語情報の統合(2018年ごろまでの主流)

視覚と自然言語の融合研究の手法について、視覚情報や自然言語の特徴量を得る機構などには共通点が多く[76]、2018年ごろまで[75]の多くの手法は、(1)視覚情報処理、(2)自然言語処理、(3)二つの情報の統合を行う3個のサブシステムを持っていた[71]。

視覚情報処理には、かつてはSIFTなどの局所画像特徴量が用いられていたが[69][68]、深層学習が適用され始めてからは主にCNNが使用されてきた[71]。2017年まではCNNが出力する特徴量をそのまま利用するモデルが多かったが、バウンディングボックスやグラフ構造を中間表現として利用する研究も行われるようになった[71]。

自然言語処理には単語ベクトルが使われることが多かったが[36]、深層学習が適用され始めてからは主にRNNで得られる文章全体の特徴量が使用されてきた[71]。

これらの手法によって得られた画像や動画と自然言語の情報を統合するための手法は、タスクごとに様々なものが利用されている[71]。CNNやRNNから得られた特徴量ベクトルを統合する最も単純な方法は、二つのベクトルを連結したりアダマール積をとることである[71]。より高度な手法として、注意機構(Attention)という手法を適用して、画像や自然言語からそれぞれのクエリに対して重要な情報を自動的に選択して利用することが提案されている[71]。

統合的な事前学習(2019年以降)

事前学習とは、機械学習のモデルを大規模なデータセットで学習することで汎用的な知識を獲得させる手法である[77]。比較的小規模のデータセットを用いて個別のタスクにチューニングを行うことで、高い性能を持つモデルを学習できる事が知られている[77]。コンピュータビジョンにおいてはCNNを大規模なデーセットで事前学習することは広く行われてきたが[77]、RNNを用いた自然言語処理で事前学習を行うことは少なかった[78][注釈 6]。2017年に発表された自然言語処理の新しいモデルであるTransformer[72]に対して事前学習を行う手法が2018年に提案され[79]、自然言語処理においても文章全体について事前学習を行う研究が行われるようになった[80]。2018年には動画にTransformerを適用する研究が提案され、2020年には画像にTransformerを適用する研究も始められた[81]。

視覚と自然言語の融合研究においても、2019年からTransformerを用いて画像・動画と自然言語の事前学習を同時に行う研究が行われている[75]。

主なタスクの手法

視覚と自然言語の融合研究の手法には共通点があるが[76][71]、タスクごとに異なる手法が研究されている[82]。ここでは主なタスクの手法を紹介する。

- 画像キャプション生成

- 研究が始められた2000年代ごろには主にテンプレートを用いた手法が提案されていた[19]。テンプレートを用いて文章を生成するためにSIFTやHOGなどの局所画像特徴量[68]に対してSVMなどの分類器を適用するなどの手法が提案された[69][70]。

- 深層学習を用いた手法が発展した2010年代には、CNNとRNNを用いる方法が一般的になった[70]。さまざまなモデルが提案されているが、単純かつ一般的に使用されている手法としては教師あり学習を用いたエンコーダ・デコーダモデルがある[83]。これは、CNNを用いて画像特徴量を抽出して、画像特徴量をRNNに入力してキャプションを生成するという手法である[84]。

- 2019年には画像と自然言語の両方にTransformerを使用する手法も提案されている[85]。

- 画像・動画への質問応答(Visual Question Answering、VQA)

- 2014年に研究が始められた当初の手法は、あらかじめ定義された形式の回答に限定されたものだったが、2015年には回答の形式を限定しないような質問にも対応できるモデルが提案された[86]。2015年に提案されたモデルのひとつは、CNNで抽出された画像の特徴量ベクトルと質問文章の単語ベクトルの両方をエンコーダのRNN(LSTM)に入力することで特徴量を統合し、デコーダのRNNで回答を生成する手法である[87]。同時期には、特徴量の統合の方法を変更したり、注意機構(Attention)やデータベースを利用する方法など、複数の手法が提案されている[87]。

- 2019年には自然言語処理にTransformerを使用するモデルや[88]、Transformerを用いて画像と自然言語の特徴量を統合的に事前学習する手法が提案されている[89]。

- 画像検索(Image Retrieval)

- さまざまな種類のクエリに対する画像検索が研究されているが[43][44]、文章か画像をクエリとする研究が多く研究されている[90]。

- 文章をクエリとする検索について、2019年でもウェブ検索では人間がつけたキャプションなどの自然言語の情報を利用しているとされている[90]。キャプションがない画像も検索するために、自動的にアノテーションを行う手法を適用することが研究されている[91]。

- 人間がつけたキャプションなどを利用しない方法として、1990年代から画像をクエリとして類似する画像を検索する研究が行なわれている[91][92]。画像をクエリとした画像検索は、画像から特徴量を抽出して類似度を評価することで行なわれる[93]。初期の研究として色、形、質感などを特徴量として使用する方法が研究されてきたが、それだけでは画像が表す意味の類似性を比較することができないことが課題だった[92]。そのため、深層学習が適用される以前から、画像全体の意味も表すような特徴量も併用する試みが研究されてきた[92]。深層学習を使用した方法も数多く提案されており、CNNを利用して画像検索に有用な特徴量を抽出する研究が行なわれている[94]。

- 文章に対する画像生成

- 2016年からGANを応用した手法が提案されていたが、文章で条件付けしない通常の画像生成と比較すると、生成される画像の質が低かった[60]。画像の質を高めるために複数のGANを使用したり、文章全体の意味を画像に反映するために注意機構(Attention)を使用する研究が提案された[60]。

- Visual Reasoning

- Visual Reasoningは視覚情報に対する質問に回答するための過程であるため[64]、VQAなどもVisual Reasoningの研究と捉えることができるが[95]、2017年からは特にVisual Reasoningの能力に注目したデータセットが提案されて研究が行なわれている[61]。

- さまざまな手法が提案されているが[61]、2017年ごろから解釈可能性の高いモデルが研究されており[64]、検出された物体同士の関係を表すシーングラフなどを使用する手法が提案されている[96][62][97]。シーングラフとは、画像中の物体をノード、物体同士の関係をエッジとするグラフである[98]。

評価手法

評価に用いられる手法はタスクによって異なる。ここでは主なタスクの評価手法を紹介する。

- 画像・動画の説明生成

- 主に使用されているのは、生成された説明とデータセットに含まれる説明の類似度による評価である[99][100]。BLEU、ROUGE、METEORといった機械翻訳などの自然言語処理タスクで使用されている評価基準が使われている[99][100]。

- 画像・動画への質問応答(VQA)

- VQAの回答は画像キャプションなどよりは短いことが多いため、単純な評価手法が使用されることが多いが、高度な評価手法も研究されている[101]。単純な手法のひとつは、生成された回答とデータセットに含まれる回答が厳密に一致しているかを評価することである[102]。高度な手法としては、回答の意味の類似度を評価する手法が研究されている[102]。

- 画像・動画に関する対話(Visual Dialog)

- 2017年[47]および2019年[103]に提案されたデータセットでは、与えられた候補の中から回答を選択するという形式のタスクになっている。そのため、これらのデータセットを用いた場合は、多クラス分類の分類精度を用いたり[103]、情報検索で用いられている評価基準が使われている[104][47]。

- 文章に対する画像生成

- GANなどのコンピュータビジョンにおける画像生成タスクで使用される評価指標が使われている[105]。Inception Scoreという指標を用いて画像の質や多様性を評価できるが、Inception Scoreでは文章に対応した画像を生成できているかを評価することができないので、R-Precisionという指標も併用される[106]。

- 視覚と言語を用いたナビゲーション

- ナビゲーションのタスクのために作られた評価指標が使われており[107]、正しい場所に案内された割合や、最終的にたどり着いた場所が正しい場所からどの程度離れているかなどが評価指標として使われている[107][66]。

データセット

大規模なデータセットを用いて学習することは、深層学習モデルの汎化性能を高める重要な要素のひとつである[108]。視覚と自然言語の融合研究においても大規模なデータセットは重要な役割を果たしており、モデル学習と評価に不可欠な存在である[16]。Flickrなどから提供される大規模な画像データとクラウドソーシングによるアノテーションによって、大規模なデータセットを作ることが可能になった[16]。既存の画像を収集するだけではなく、データセットのために作成されることもある[66]。

さまざまなデータセットが提案されているが、データセットのサイズ(含まれる画像や文章の数)、画像の質や多様性、文章の長さ、文章に含まれる単語や構文の多様性、アノテーションの豊富さなどの異なる性質を持っており[109]、それぞれのデータセットに利点と欠点がある[16]。

本節では主なデータセットを紹介する[注釈 7]。

画像・動画の説明生成

データセットには画像と説明が含まれるが、データセットによってデータの数や質、収集方法などが異なる[111]。

キャプション付き画像データセット

| 名称 | 発表年 | 画像の枚数 | 各画像のキャプション数 | 特徴 | 出典 |

|---|---|---|---|---|---|

| SBU Captioned Photo Dataset | 2011 | 1,000,000 | 1 | Flickrから集められた写真で、ユーザがつけたキャプションを利用している。 | [112] |

| Flickr 30K Images | 2014 | 31,014 | 5 | Flickrから集められた写真に対して、クラウドソーシングでキャプションを付けている。 | [113] |

| Microsoft COCO Dataset | 2014 | 123,287 | 5 | Flickrから集められた写真に対して、クラウドソーシングでキャプションを付けている。広く利用されているデータセット[114]。 | [115] |

説明付き動画データセット

| 名称 | 発表年 | 動画の数 | 動画の合計時間 | 文章の数 | 特徴 | 出典 |

|---|---|---|---|---|---|---|

| Microsoft Research Video Description Corpus | 2011 | 1,970 | 5.3時間 | 70,028 | YouTubeの動画に、クラウドソーシングで説明をつけている。複数言語の説明がつけられている。 | [116] |

画像への質問応答

異なる特徴を持ったさまざまなデータセットが提案されている。実世界の画像を用いたデータセットが良く使われているが[117]、画像認識の能力ではなく意味を理解できているかの評価に注目するために、クリップアートで作成された絵を用いたデータセットも提案されている[118]。初期のデータセットは画像中の情報を理解できれば質問に答えられるものであったが、2015年に発表されたKB-VQAというデータセットなどは、画像中の情報だけでは質問に正しく回答することはできず、外部データベースの知識を用いることが求められる[118]。2017年に発表されたVisual Genomeというデータセットでは、画像のシーングラフが与えられている[119]。

| 名称 | 発表年 | 画像の枚数 | 質問の数 | 回答の数 | 説明 | 出典 |

|---|---|---|---|---|---|---|

| Visual Question Answering Dataset (v1.0) | 2015 | 204,721 + 50,000 | 614,163 + 150,000 | 6,141,630 + 1,500,000 | MS COCOの画像(204,721枚)とクリップアートで作成された絵(50,000枚)に対して、クラウドソーシングで質問と回答がつけられている。 | [120] |

課題

データセットバイアス

データセットバイアスとは、機械学習モデルの学習に使用したときに誤った結論を導く可能性がある、データセットの偏りのことである[121]。例えば、画像データセットを用いて「自動車」を認識する機械学習モデルを学習するときに、「ImageNet」というデータセットでは「自動車」というラベルにスポーツカーを多く含むため、自家用車の検出性能が低くなってしまうという問題が起こることがある[122]。逆に、学習データとテストデータは多くの場合は同じ条件で集められているため、学習データを記憶するだけでテストデータにも対応できてしまい、実際の性能よりも高く評価されてしまうという問題が起こることもある[21]。

データセットバイアスはコンピュータビジョンや自然言語処理のそれぞれの分野でも問題となるが、両方の分野を対象とする融合研究ではより深刻な影響を受けるとされている[21][123]。一例として、VQAのデータセットにおいて、質問に対する回答に偏りがあると画像を使わなくても一定の精度を達成できてしまうことが知られている[21][10]。例えばデータセットに「画像中に〜がありますか」という形式の質問が複数あり、答えとして「はい」が多いという偏りがあるとする[21]。機械学習モデルは画像の内容を確認して答えることが期待されるが、自然言語の質問だけを見て「画像中に〜がありますか」という形式の質問には常に「はい」と答えるように学習をされてしまうことが起こり得る[21][10]。

解決方法としてデータセットからバイアスを取り除く方法が研究されているが、大規模なデータセットにおいてあらゆる要素のバイアスを取り除くことは不可能に近く、未解決の問題とされている[21]。

評価の難しさ

評価手法はコンピュータビジョンと自然言語処理の各分野においても課題のひとつであるが、融合研究においてはさらに大きな問題となっているとされている[22]。特に自然言語生成に関係するタスクにおける評価は難しいとされる[22][124][125]。例えば画像キャプション生成において「男性が木の横を歩いている」と「男が木のそばを散歩している」という二つの文章はほとんど同じ意味を表しているが、自動的に類似度の評価を行うことは難しい[22]。また、VQAにおいて「鳥」という答えが正解とされている問題に対して、「鷹」という答えが正しいのかどうかを自動的に評価することは難しい[22]。

評価手法を改善する研究は行われているが、未解決の問題となっている[22]。

脚注

注釈

- ^ 日本語での表記は複数存在し、「視覚と自然言語の融合研究」[1]、「視覚と言語の融合研究」[2][3]、「画像と自然言語処理の融合研究」[4]、「CVとNLPの融合研究」[5]などの他に"Vision and Language"と英語のままで呼ばれることもある[6][7]。

- ^ "Vision and Language"[8][9][10]の他に"Language and Vision"[11]など表記に揺らぎはある。

- ^ 自然言語処理分野において、与えられた文章の次の文章を生成する「条件付き言語生成」は広く研究されているが、これを拡張した、与えられた画像や動画に対して「条件付き言語生成」をするというタスクとして捉えることもできる[36]。

- ^ コンピュータビジョンで画像に対する画像の生成(白黒写真からカラー写真の生成など[59])などが研究されているが、これを自然言語との融合分野に拡張したタスクとして捉えることもできる[36]。

- ^ 未知の物体なども対象とした(open-world)手法として初めて提案されたのがMalinowski et al. (2014)[10]である[41]。

- ^ 自然言語処理分野においては、単語ベクトルを事前学習することは広く研究されてきた[78]。

- ^ サーベイ論文[110][9]で挙げられているデータセットを中心に取り上げる。

出典

- ^ a b c d 牛久祥孝. “【記事更新】私のブックマーク「視覚と自然言語の融合研究(Integrating Vision and Language)」 – 人工知能学会 (The Japanese Society for Artificial Intelligence)”. 人工知能学会. 2022年3月24日閲覧。

- ^ “NL研・CVIM研・PRMU研の合同研究会:第248回自然言語処理研究会 発表募集”. 情報処理学会 自然言語処理研究会 (NL) (2021年2月9日). 2022年3月24日閲覧。

- ^ “【第48回AIセミナー】「マルチモーダル情報の統合理解の最前線」”. 人工知能研究センター. 2022年3月24日閲覧。

- ^ a b c “AI白書2017:IPA 独立行政法人 情報処理推進機構”. 情報処理推進機構. p. 42. 2022年3月24日閲覧。

- ^ a b c 一般社団法人情報処理学会. “第247回NL研究発表会-情報処理学会”. www.ipsj.or.jp. 2022年3月24日閲覧。

- ^ 井尻, 善久; 牛久, 祥孝; 片岡, 裕雄; 藤吉, 弘亘, eds. (2021). コンピュータビジョン最前線 Winter 2021. 共立出版. p. 78.

- ^ 品川, 政太朗「Vision and Languageと分野を取り巻く深層学習手法の紹介」『研究報告コンピュータビジョンとイメージメディア(CVIM)』2021-CVIM-226第15号、2021年5月13日、1–1頁、ISSN 2188-8701。

- ^ “Workshop on Vision and Language - ACL Anthology”. ACL Anthology. ACL. 2022年3月24日閲覧。

- ^ a b Mogadala, Kalimuthu & Klakow 2021.

- ^ a b c d e Antol, Stanislaw; Agrawal, Aishwarya; Lu, Jiasen; Mitchell, Margaret; Batra, Dhruv; Lawrence Zitnick, C.; Parikh, Devi (2015). “VQA: Visual Question Answering”. Proceedings of the IEEE International Conference on Computer Vision (ICCV): 2425–2433. 引用エラー: 無効な

<ref>タグ; name ":1"が異なる内容で複数回定義されています - ^ “CVPR 2015 Language and Vision Workshop | The Center for Brains, Minds & Machines”. Center for Brain, Minds & Machines. 2022年3月24日閲覧。

- ^ a b Mogadala, Kalimuthu & Klakow 2021, p. 1183.

- ^ a b Ferraro 2015, p. 210.

- ^ [1][4][13]

- ^ [1][10][13]

- ^ a b c d e f g h Ferraro 2015, p. 207.

- ^ a b c Terry Winograd. “SHRDLU”. 2022年3月24日閲覧。

- ^ a b c Kafle 2019, 2.1. Tasks in V&L Research.

- ^ a b c d Wang 2021, p. 2.

- ^ a b c Kafle 2019, 1. Introduction.

- ^ a b c d e f g Kafle 2019, 3.1. Dataset Bias.

- ^ a b c d e f Kafle 2019, 3.2. Evaluation Metrics.

- ^ Mogadala, Kalimuthu & Klakow 2021, pp. 1183–1184.

- ^ Sonka 2008, p. 1.

- ^ Huang, T (1996) (英語). Computer Vision: Evolution And Promise. doi:10.5170/CERN-1996-008.21.

- ^ “コンピューター ビジョンとは | Microsoft Azure”. Microsoft. 2022年4月8日閲覧。

- ^ a b Mogadala, Kalimuthu & Klakow 2021, p. 1185.

- ^ Sonka 2008, p. 385.

- ^ Cao, Yang-Jie; Jia, Li-Li; Chen, Yong-Xia; Lin, Nan; Yang, Cong; Zhang, Bo; Liu, Zhi; Li, Xue-Xiang et al. (2019). “Recent Advances of Generative Adversarial Networks in Computer Vision”. IEEE Access 7: 14985–15006. doi:10.1109/ACCESS.2018.2886814. ISSN 2169-3536.

- ^ Wang, Zhengwei; She, Qi; Ward, Tomás E. (2022-03-31). “Generative Adversarial Networks in Computer Vision: A Survey and Taxonomy” (英語). ACM Computing Surveys 54 (2): 1–38. doi:10.1145/3439723. ISSN 0360-0300.

- ^ a b c Jurafsky 2009, p. 1.

- ^ Eisenstein 2019, p. 1.

- ^ Jurafsky 2009, p. 737.

- ^ a b Eisenstein 2019, p. 424.

- ^ Eisenstein 2019, p. 431.

- ^ a b c d e f g h i j k l m n Mogadala, Kalimuthu & Klakow 2021, p. 1187.

- ^ Baltrušaitis 2019, p. 424.

- ^ Mogadala, Kalimuthu & Klakow 2021, p. 1190.

- ^ Jurafsky 2009, p. 779.

- ^ Jurafsky 2009, p. 780.

- ^ a b Wu 2017, p. 3.

- ^ a b c Mezaris, V.; Kompatsiaris, I.; Strintzis, M.G. (2003-09). “An ontology approach to object-based image retrieval”. Proceedings 2003 International Conference on Image Processing (Cat. No.03CH37429) 2: II–511. doi:10.1109/ICIP.2003.1246729.

- ^ a b Datta 2008, pp. 11–12.

- ^ a b Latif 2019, p. 3.

- ^ Datta 2008, p. 4.

- ^ Mogadala, Kalimuthu & Klakow 2021, p. 1246.

- ^ a b c d Das, Abhishek; Kottur, Satwik; Gupta, Khushi; Singh, Avi; Yadav, Deshraj; Moura, Jose M. F.; Parikh, Devi; Batra, Dhruv (2017). Visual Dialog. pp. 326–335.

- ^ 船越, 孝太郎; 渡辺, 聖; 栗山, 直子; 徳永, 健伸 (2006). “知覚的群化に基づく参照表現の生成”. 自然言語処理 13 (2): 79–97. doi:10.5715/jnlp.13.2_79.

- ^ Mogadala, Kalimuthu & Klakow 2021, p. 1216.

- ^ Kazemzadeh, Sahar; Ordonez, Vicente; Matten, Mark; Berg, Tamara (2014-10). “ReferItGame: Referring to Objects in Photographs of Natural Scenes”. Proceedings of the 2014 Conference on Empirical Methods in Natural Language Processing (EMNLP) (Doha, Qatar: Association for Computational Linguistics): 787–798. doi:10.3115/v1/D14-1086.

- ^ Krahmer 2012, p. 207.

- ^ a b Mao, Junhua; Huang, Jonathan; Toshev, Alexander; Camburu, Oana; Yuille, Alan; Murphy, Kevin (2016-06). “Generation and Comprehension of Unambiguous Object Descriptions”. 2016 IEEE Conference on Computer Vision and Pattern Recognition (CVPR) (Las Vegas, NV, USA: IEEE): 11–20. doi:10.1109/CVPR.2016.9. ISBN 978-1-4673-8851-1.

- ^ Qiao 2021, p. 4427.

- ^ 寺中, 元希; 斎藤, 博昭 (2015). “含意関係認識におけるベクトル空間モデルの適用”. 自然言語処理学会 21: 924.

- ^ Mogadala, Kalimuthu & Klakow 2021, p. 1241.

- ^ a b Specia, Lucia; Frank, Stella; Sima'an, Khalil; Elliott, Desmond (2016-08). “A Shared Task on Multimodal Machine Translation and Crosslingual Image Description”. Proceedings of the First Conference on Machine Translation: Volume 2, Shared Task Papers (Berlin, Germany: Association for Computational Linguistics): 543–553. doi:10.18653/v1/W16-2346.

- ^ “CLEVR: A Diagnostic Dataset for Compositional Language and Elementary Visual Reasoning”. cs.stanford.edu. 2022年3月25日閲覧。

- ^ CLEVR Dataset Generation, Meta Research, (2022-03-16) 2022年3月25日閲覧。

- ^ Isola, Phillip; Zhu, Jun-Yan; Zhou, Tinghui; Efros, Alexei A. (2017-07). “Image-to-Image Translation with Conditional Adversarial Networks”. 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR): 5967–5976. doi:10.1109/CVPR.2017.632.

- ^ a b c Mogadala, Kalimuthu & Klakow 2021, p. 1258.

- ^ a b c Mogadala, Kalimuthu & Klakow 2021, p. 1232.

- ^ a b c Bakhtin, Anton; van der Maaten, Laurens; Johnson, Justin; Gustafson, Laura; Girshick, Ross (2019). “PHYRE: A New Benchmark for Physical Reasoning”. Advances in Neural Information Processing Systems (Curran Associates, Inc.) 32.

- ^ a b Johnson, Justin; Hariharan, Bharath; Van Der Maaten, Laurens; Hoffman, Judy; Fei-Fei, Li; Zitnick, C. Lawrence; Girshick, Ross (2017-10). “Inferring and Executing Programs for Visual Reasoning”. 2017 IEEE International Conference on Computer Vision (ICCV): 3008–3017. doi:10.1109/ICCV.2017.325.

- ^ a b c d He 2021, p. 2.

- ^ Zieliński, P.; Markowska-Kaczmar, U. (2021-10-01). “3D robotic navigation using a vision-based deep reinforcement learning model” (英語). Applied Soft Computing 110: 107602. doi:10.1016/j.asoc.2021.107602. ISSN 1568-4946.

- ^ a b c d Anderson, Peter; Wu, Qi; Teney, Damien; Bruce, Jake; Johnson, Mark; Sunderhauf, Niko; Reid, Ian; Gould, Stephen et al. (2018-06). “Vision-and-Language Navigation: Interpreting Visually-Grounded Navigation Instructions in Real Environments”. 2018 IEEE/CVF Conference on Computer Vision and Pattern Recognition (Salt Lake City, UT: IEEE): 3674–3683. doi:10.1109/CVPR.2018.00387. ISBN 978-1-5386-6420-9.

- ^ Datta 2008, p. 5.

- ^ a b c 庄野逸 (2013). “局所画像特徴量 ~ SIFT, HOG を題材に~”. 映像情報メディア学会誌 67 (3): 256~258.

- ^ a b c Farhadi, Ali; Hejrati, Mohsen; Sadeghi, Mohammad Amin; Young, Peter; Rashtchian, Cyrus; Hockenmaier, Julia; Forsyth, David (2010). Daniilidis, Kostas; Maragos, Petros; Paragios, Nikos. eds. “Every Picture Tells a Story: Generating Sentences from Images” (英語). Computer Vision – ECCV 2010 (Berlin, Heidelberg: Springer): 15–29. doi:10.1007/978-3-642-15561-1_2. ISBN 978-3-642-15561-1.

- ^ a b c Hossain 2019, p. 2.

- ^ a b c d e f g h i Kafle 2019, 2.2. V&L Algorithms.

- ^ a b Vaswani, Ashish; Shazeer, Noam; Parmar, Niki; Uszkoreit, Jakob; Jones, Llion; Gomez, Aidan N; Kaiser, Łukasz; Polosukhin, Illia (2017). “Attention is All you Need”. Advances in Neural Information Processing Systems (Curran Associates, Inc.) 30.

- ^ Parmar, Niki; Vaswani, Ashish; Uszkoreit, Jakob; Kaiser, Lukasz; Shazeer, Noam; Ku, Alexander; Tran, Dustin (2018-07-03). “Image Transformer” (英語). International Conference on Machine Learning (PMLR): 4055–4064.

- ^ Mogadala, Kalimuthu & Klakow 2021, p. 1270.

- ^ a b c Uppal 2022, p. 161.

- ^ a b Mogadala, Kalimuthu & Klakow 2021, p. 1189.

- ^ a b c He, Kaiming; Girshick, Ross; Dollar, Piotr (2019-10). “Rethinking ImageNet Pre-Training”. 2019 IEEE/CVF International Conference on Computer Vision (ICCV) (Seoul, Korea (South): IEEE): 4917–4926. doi:10.1109/ICCV.2019.00502. ISBN 978-1-7281-4803-8.

- ^ a b Qiu 2020, p. 1872.

- ^ Devlin, Jacob; Chang, Ming-Wei; Lee, Kenton; Toutanova, Kristina (2019). “BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding” (英語). Proceedings of the 2019 Conference of the North (Minneapolis, Minnesota: Association for Computational Linguistics): 4171–4186. doi:10.18653/v1/N19-1423.

- ^ Qiu 2020, p. 1873.

- ^ Han 2022, p. 1.

- ^ Uppal 2022, p. 149.

- ^ Hossain 2019, pp. 4, 11.

- ^ Hossain 2019, pp. 11.

- ^ Uppal 2022, p. 153.

- ^ Qi 2017, p. 22.

- ^ a b Qi 2017, p. 23.

- ^ Uppal 2022, p. 155.

- ^ Zhou, Luowei; Palangi, Hamid; Zhang, Lei; Hu, Houdong; Corso, Jason; Gao, Jianfeng (2020-04-03). “Unified Vision-Language Pre-Training for Image Captioning and VQA”. Proceedings of the AAAI Conference on Artificial Intelligence 34 (07): 13041–13049. doi:10.1609/aaai.v34i07.7005. ISSN 2374-3468.

- ^ a b Latif 2019, p. 1.

- ^ a b Latif 2019, p. 2.

- ^ a b c Kapoor 2021, p. 29562.

- ^ Kapoor 2021, p. 29561.

- ^ Kapoor 2021, pp. 29563–29571.

- ^ Johnson, Justin; Hariharan, Bharath; van der Maaten, Laurens; Fei-Fei, Li; Zitnick, C. Lawrence; Girshick, Ross (2017-07). “CLEVR: A Diagnostic Dataset for Compositional Language and Elementary Visual Reasoning”. 2017 IEEE Conference on Computer Vision and Pattern Recognition (CVPR) (Honolulu, HI: IEEE): 1988–1997. doi:10.1109/CVPR.2017.215. ISBN 978-1-5386-0457-1.

- ^ Mogadala, Kalimuthu & Klakow 2021, pp. 1187, 1233.

- ^ He 2021, p. 3.

- ^ He 2021, p. 5.

- ^ a b Mogadala, Kalimuthu & Klakow 2021, p. 1198.

- ^ a b Sharma 2020, p. 327.

- ^ Wu 2017, p. 22.

- ^ a b Wu 2017, p. 30.

- ^ a b Kottur, Satwik; Moura, José M. F.; Parikh, Devi; Batra, Dhruv; Rohrbach, Marcus (2019-06). “CLEVR-Dialog: A Diagnostic Dataset for Multi-Round Reasoning in Visual Dialog”. Proceedings of the 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies, Volume 1 (Long and Short Papers) (Minneapolis, Minnesota: Association for Computational Linguistics): 582–595. doi:10.18653/v1/N19-1058.

- ^ Mogadala, Kalimuthu & Klakow 2021, p. 1248.

- ^ Mogadala, Kalimuthu & Klakow 2021, p. 1261.

- ^ Li, Bowen; Qi, Xiaojuan; Lukasiewicz, Thomas; Torr, Philip (2019). “Controllable Text-to-Image Generation”. Advances in Neural Information Processing Systems (Curran Associates, Inc.) 32.

- ^ a b Mogadala, Kalimuthu & Klakow 2021, p. 1268.

- ^ Goodfellow 2016, p. 19.

- ^ Ferraro 2015, p. 208.

- ^ Ferraro 2015.

- ^ Mogadala, Kalimuthu & Klakow 2021, p. 1193.

- ^ “Im2Text: Describing Images Using 1 Million Captioned Photographs”. Vicente Ordonez. 2022年3月25日閲覧。

- ^ Young, Peter; Lai, Alice; Hodosh, Micah; Hockenmaier, Julia (2014). “From image descriptions to visual denotations: New similarity metrics for semantic inference over event descriptions”. Transactions of the Association for Computational Linguistics 2: 67–78. doi:10.1162/tacl_a_00166.

- ^ Mogadala, Kalimuthu & Klakow 2021, p. 1195.

- ^ Lin, Tsung-Yi; Maire, Michael; Belongie, Serge; Hays, James; Perona, Pietro; Ramanan, Deva; Dollár, Piotr; Zitnick, C. Lawrence (2014). Fleet, David; Pajdla, Tomas; Schiele, Bernt et al.. eds. “Microsoft COCO: Common Objects in Context” (英語). Computer Vision – ECCV 2014 (Cham: Springer International Publishing): 740–755. doi:10.1007/978-3-319-10602-1_48. ISBN 978-3-319-10602-1.

- ^ Chen, David; Dolan, William (2011-06). “Collecting Highly Parallel Data for Paraphrase Evaluation”. Proceedings of the 49th Annual Meeting of the Association for Computational Linguistics: Human Language Technologies (Portland, Oregon, USA: Association for Computational Linguistics): 190–200.

- ^ Wu 2017, p. 28.

- ^ a b Wu 2017, p. 33.

- ^ Wu 2017, p. 34.

- ^ “Visual Question Answering” (英語). Visual Question Answering. 2022年3月25日閲覧。

- ^ Tommasi, Tatiana; Patricia, Novi; Caputo, Barbara; Tuytelaars, Tinne (2017), “A Deeper Look at Dataset Bias”, in Csurka, Gabriela (英語), Domain Adaptation in Computer Vision Applications, Springer International Publishing, p. 39, doi:10.1007/978-3-319-58347-1_2, ISBN 978-3-319-58347-1

- ^ Torralba, Antonio; Efros, Alexei A. (2011-06). “Unbiased look at dataset bias”. CVPR 2011: 1521–1528. doi:10.1109/CVPR.2011.5995347.

- ^ Margaret Mitchell. “Bias in the Vision and Language of Artificial Intelligence”. 2022年4月8日閲覧。

- ^ Iqbal 2020, p. 12.

- ^ Novikova, Jekaterina; Dušek, Ondřej; Cercas Curry, Amanda; Rieser, Verena (2017). “Why We Need New Evaluation Metrics for NLG” (英語). Proceedings of the 2017 Conference on Empirical Methods in Natural Language Processing (Copenhagen, Denmark: Association for Computational Linguistics): 2241–2252. doi:10.18653/v1/D17-1238.

参考文献

書籍

- Goodfellow, Ian; Bengio, Yoshua; Courville, Aaron (2016-11-18) (英語). Deep Learning. Cambridge, MA, USA: MIT Press. ISBN 978-0-262-03561-3

- Milan Sonka; Vaclav Hlavac; Roger Boyle (2008). Image Processing, Analysis, and Machine Vision. Thomson. ISBN 978-0-495-08252-1

- Jurafsky, Daniel; Martin, James H. (2009). Speech and language processing : an introduction to natural language processing, computational linguistics, and speech recognition (Second edition ed.). Prentice Hall. ISBN 978-0-13-187321-6. OCLC 213375806

- Eisenstein, Jacob (2019). Introduction to natural language processing. Cambridge, Massachusetts: The MIT Press. ISBN 978-0-262-04284-0. OCLC 1080249173

サーベイ論文(視覚と自然言語の融合研究について)

分野全体について

- Ferraro, Francis; Mostafazadeh, Nasrin; Huang, Ting-Hao; Vanderwende, Lucy; Devlin, Jacob; Galley, Michel; Mitchell, Margaret (2015-09). “A Survey of Current Datasets for Vision and Language Research”. Proceedings of the 2015 Conference on Empirical Methods in Natural Language Processing (Lisbon, Portugal: Association for Computational Linguistics): 207–213. doi:10.18653/v1/D15-1021.

- Baltrušaitis, Tadas; Ahuja, Chaitanya; Morency, Louis-Philippe (2019-02). “Multimodal Machine Learning: A Survey and Taxonomy”. IEEE Transactions on Pattern Analysis and Machine Intelligence 41 (2): 423–443. doi:10.1109/TPAMI.2018.2798607. ISSN 1939-3539.

- Kafle, Kushal; Shrestha, Robik; Kanan, Christopher (2019). “Challenges and Prospects in Vision and Language Research”. Frontiers in Artificial Intelligence 2. doi:10.3389/frai.2019.00028/full. ISSN 2624-8212.

- Uppal, Shagun; Bhagat, Sarthak; Hazarika, Devamanyu; Majumder, Navonil; Poria, Soujanya; Zimmermann, Roger; Zadeh, Amir (2022-01-01). “Multimodal research in vision and language: A review of current and emerging trends” (英語). Information Fusion 77: 149–171. doi:10.1016/j.inffus.2021.07.009. ISSN 1566-2535.

- Mogadala, Aditya; Kalimuthu, Marimuthu; Klakow, Dietrich (2021-08-30). “Trends in Integration of Vision and Language Research: A Survey of Tasks, Datasets, and Methods” (英語). Journal of Artificial Intelligence Research 71: 1183–1317. doi:10.1613/jair.1.11688. ISSN 1076-9757.

それぞれのタスクについて

- Hossain, MD. Zakir; Sohel, Ferdous; Shiratuddin, Mohd Fairuz; Laga, Hamid (2019-02-04). “A Comprehensive Survey of Deep Learning for Image Captioning”. ACM Computing Surveys 51 (6): 1–36. doi:10.1145/3295748. ISSN 0360-0300.

- Sharma, Himanshu; Agrahari, Manmohan; Singh, Sujeet Kumar; Firoj, Mohd; Mishra, Ravi Kumar (2020-02). “Image Captioning: A Comprehensive Survey”. 2020 International Conference on Power Electronics IoT Applications in Renewable Energy and its Control (PARC): 325–328. doi:10.1109/PARC49193.2020.236619.

- Wang, Chaoyang; Zhou, Ziwei; Xu, Liang (2021-01). “An Integrative Review of Image Captioning Research” (英語). Journal of Physics: Conference Series 1748 (4): 042060. doi:10.1088/1742-6596/1748/4/042060. ISSN 1742-6596.

- Wu, Qi; Teney, Damien; Wang, Peng; Shen, Chunhua; Dick, Anthony; van den Hengel, Anton (2017-10-01). “Visual question answering: A survey of methods and datasets” (英語). Computer Vision and Image Understanding 163: 21–40. doi:10.1016/j.cviu.2017.05.001. ISSN 1077-3142.

- Datta, Ritendra; Joshi, Dhiraj; Li, Jia; Wang, James Z. (2008-04). “Image retrieval: Ideas, influences, and trends of the new age” (英語). ACM Computing Surveys 40 (2): 1–60. doi:10.1145/1348246.1348248. ISSN 0360-0300.

- Dureja, Aman; Pahwa, Payal (2017-12-28). “Image retrieval techniques: a survey”. International Journal of Engineering & Technology 7 (1.2): 215. doi:10.14419/ijet.v7i1.2.9231. ISSN 2227-524X.

- Latif, Afshan; Rasheed, Aqsa; Sajid, Umer; Ahmed, Jameel; Ali, Nouman; Ratyal, Naeem Iqbal; Zafar, Bushra; Dar, Saadat Hanif et al. (2019-08-26). “Content-Based Image Retrieval and Feature Extraction: A Comprehensive Review” (英語). Mathematical Problems in Engineering 2019: e9658350. doi:10.1155/2019/9658350. ISSN 1024-123X.

- Kapoor, Rajiv; Sharma, Deepak; Gulati, Tarun (2021-08-01). “State of the art content based image retrieval techniques using deep learning: a survey” (英語). Multimedia Tools and Applications 80 (19): 29561–29583. doi:10.1007/s11042-021-11045-1. ISSN 1573-7721.

- Krahmer, Emiel; van Deemter, Kees (2012-03). “Computational Generation of Referring Expressions: A Survey”. Computational Linguistics 38 (1): 173–218. doi:10.1162/COLI_a_00088.

- Qiao, Yanyuan; Deng, Chaorui; Wu, Qi (2021). “Referring Expression Comprehension: A Survey of Methods and Datasets”. IEEE Transactions on Multimedia 23: 4426–4440. doi:10.1109/TMM.2020.3042066. ISSN 1941-0077.

- He, Feijuan; Wang, Yaxian; Miao, Xianglin; Sun, Xia (2021-08-01). “Interpretable visual reasoning: A survey” (英語). Image and Vision Computing 112: 104194. doi:10.1016/j.imavis.2021.104194. ISSN 0262-8856.

サーベイ論文(コンピュータビジョンおよび自然言語処理について)

- Qiu, XiPeng; Sun, TianXiang; Xu, YiGe; Shao, YunFan; Dai, Ning; Huang, XuanJing (2020-10-01). “Pre-trained models for natural language processing: A survey” (英語). Science China Technological Sciences 63 (10): 1872–1897. doi:10.1007/s11431-020-1647-3. ISSN 1869-1900.

- Khan, Salman; Naseer, Muzammal; Hayat, Munawar; Zamir, Syed Waqas; Khan, Fahad Shahbaz; Shah, Mubarak (2021-12-07). “Transformers in Vision: A Survey”. ACM Computing Surveys. doi:10.1145/3505244. ISSN 0360-0300.

- Han, Kai; Wang, Yunhe; Chen, Hanting; Chen, Xinghao; Guo, Jianyuan; Liu, Zhenhua; Tang, Yehui; Xiao, An et al. (2022). “A Survey on Vision Transformer”. IEEE Transactions on Pattern Analysis and Machine Intelligence. doi:10.1109/TPAMI.2022.3152247. ISSN 0162-8828.

- Iqbal, Touseef; Qureshi, Shaima (2020-04-13). “The survey: Text generation models in deep learning” (英語). Journal of King Saud University - Computer and Information Sciences. doi:10.1016/j.jksuci.2020.04.001. ISSN 1319-1578.