「スイスチーズモデル」の版間の差分

Butanekotomato (会話 | 投稿記録) 編集の要約なし |

ページ「Schweizer-Käse-Modell」の翻訳により作成 |

||

| 1行目: | 1行目: | ||

{{出典の明記|date=2019年11月17日 (日) 02:25 (UTC)}} |

{{出典の明記| date = 2019年11月17日 (日) 02:25 (UTC)}} |

||

| ⚫ | '''スイスチーズモデル'''({{Lang-en-short|Swiss cheese model}})は、[[マンチェスター大学]]のジェームズ・リーズンが提唱し実証した<ref name="Reas2000">{{Cite book|author=James Reason|title=Human error: models and management|volume=320|issue=7237|date=2000-03-18|pages=768–770|doi=10.1136/bmj.320.7237.768|pmc=1117770|pmid=10720363}}</ref>、[[航空安全]]、[[工学]]、[[医療]]の場などで使われる[[リスクマネジメント]]の基礎概念である。 |

||

| ⚫ | |||

| ⚫ | |||

穴の空いている[[スイスチーズ]]を策に見立て重ねることで貫通するリスクを[[冗長化]]している。 |

穴の空いている[[スイスチーズ]]を策に見立て重ねることで貫通するリスクを[[冗長化]]している。 |

||

{{stub}} |

|||

複雑なシステムの崩壊への貢献としての潜在的で活発な[[ヒューマンエラー|人為的なエラーの]]図解表現であり、 事故の原因の連鎖を説明するもの <ref name="Reas1990">{{Cite book|author=James Reason|title=The Contribution of Latent Human Failures to the Breakdown of Complex Systems|volume=327|issue=1241|date=1990-04-12|pages=475–484|doi=10.1098/rstb.1990.0090}} ({{JSTOR|55319}})</ref> 。 |

|||

スイスチーズモデルでは、安全性のレベルとチーズスライスを前後に比較。 [[エメンタールチーズ|Emmentaler]]などのチーズの穴は、セキュリティシステムの[[保安|安全性]]または[[保安|セキュリティ]] [[シュッツ|対策の]]欠陥を反映。 弱点としてのチーズの穴は、予想外にサイズと位置を変える可能性があり、多くの原因因子の好ましくない組み合わせの場合、個々のエラーは[[損傷]] 、 [[事故|事故、]]または[[災害|壊滅的な結果に]]発展。 このモデルでは、チーズの穴が一直線に並び、 [[弾道]]の機会が生じる、とすべての安全障壁を克服した理由として述べる <ref name="Reas1990">{{Cite book|author=James Reason|title=The Contribution of Latent Human Failures to the Breakdown of Complex Systems|volume=327|issue=1241|date=1990-04-12|pages=475–484|doi=10.1098/rstb.1990.0090}} ({{JSTOR|55319}})</ref> <ref name="Reas2000">{{Cite book|author=James Reason|title=Human error: models and management|volume=320|issue=7237|date=2000-03-18|pages=768–770|doi=10.1136/bmj.320.7237.768|pmc=1117770|pmid=10720363}}</ref> 。モデル代わりに、スイスチーズも有用な[[メタファー]]として見ることができる。 <ref name="Resil">{{Cite book|title=Resilience Engineering: Concepts and Precepts|publisher=Ashgate Publishing|date=2006|isbn=978-0-7546-4641-9}}</ref> |

|||

| ⚫ | |||

== 遅延エラーとアクティブエラー == |

|||

理由は、 [[スリーマイル島原子力発電所事故|スリーマイル島]] 、 [[ボパール化学工場事故|ボパール]] 、 [[STS-51-L|チャレンジャー]] 、 [[キングス・クロス火災|キングスクロス]] 、 [[チェルノブイリ原子力発電所事故|チェルノブイリ、]] ゼーブルッヘなどの災害からの事故報告を調査し、アクティブな故障と潜在的な故障の区別を示唆している <ref name="Reas1990">{{Cite book|author=James Reason|title=The Contribution of Latent Human Failures to the Breakdown of Complex Systems|volume=327|issue=1241|date=1990-04-12|pages=475–484|doi=10.1098/rstb.1990.0090}} ({{JSTOR|55319}})</ref>。その後、彼は個人的なシステムエラーのことを話しており <ref name="Reas2000">{{Cite book|author=James Reason|title=Human error: models and management|volume=320|issue=7237|date=2000-03-18|pages=768–770|doi=10.1136/bmj.320.7237.768|pmc=1117770|pmid=10720363}}</ref> 、理由や仮設は ほとんどの事故は組織の影響、監視、前提条件、および具体的な行動の4つの障害領域のうちの1つ以上にまでさかのぼることができると[[仮説|仮定]]しており、繰延[[エラー]]の[[システム|システムを]]有害前に長いされているイベントの[[経営管理論|管理と組織レベル]]の前に作成されている危険な行為のことで一緒に不利な状況と個別に、[[人間|人々]]の事故につながったとしている(アクティブな失敗)。 |

|||

== アプリケーション == |

|||

事故原因のスイスチーズモデルはリスク分析と[[リスクマネジメント|リスク管理に]]使用されており [[保安|セキュリティ]]と[[保安|セキュリティ]]を[[企画|計画する]]ための出発点で [[工学]] <ref name="Resil">{{Cite book|title=Resilience Engineering: Concepts and Precepts|publisher=Ashgate Publishing|date=2006|isbn=978-0-7546-4641-9}}</ref>および[[医療制度|医療]] [[鉄道輸送]] および[[航空|航空学]]など システムセキュリティのため仕事と組織心理学で適用されている <ref>{{Cite book|author=Friedemann W. Nerdinger, Gerhard Blickle, Niclas Schaper|title=Arbeits- und Organisationspsychologie|publisher=Springer|date=2008|pages=501f|url=http://link.springer.com/book/10.1007/978-3-540-74705-5}}</ref>。 |

|||

== エラー:人またはシステム == |

|||

有害なイベントでは、告発は通常、「最前線」の俳優に対するものである( {{Lang-en|''front line''}} )。 <ref name="Reas1990">{{Cite book|author=James Reason|title=The Contribution of Latent Human Failures to the Breakdown of Complex Systems|volume=327|issue=1241|date=1990-04-12|pages=475–484|doi=10.1098/rstb.1990.0090}} ({{JSTOR|55319}})</ref> ただし、Reasonによる損害または不幸の考慮は、個人エラーまたはシステムエラーの2つの方法で行うことができる <ref name="Reas2000">{{Cite book|author=James Reason|title=Human error: models and management|volume=320|issue=7237|date=2000-03-18|pages=768–770|doi=10.1136/bmj.320.7237.768|pmc=1117770|pmid=10720363}}</ref>。 |

|||

== 事故の原因の理論とモデル == |

|||

事故の原因を理解するにあたり、Reasonは何年も人々が使用しているアプローチとは区別している。 個人的なアプローチ<ref name="theo">Abdul Raouf: ''Theory of accident causes.'' In: Jeanne Mager Stellman (Hrsg.): ''Encyclopaedia of occupational health and safety.'' 4. Auflage. International Labour Office, Genf 1998, ISBN 92-2-109203-8, Part VIII. Accident prevention, S. 56.6.</ref>理論では、主に「忘れっぽさ、不注意、やる気、怠慢、過失、不注意」で、人間の安全でない行為または不作為に考慮される<ref name="Reas2000">{{Cite book|author=James Reason|title=Human error: models and management|volume=320|issue=7237|date=2000-03-18|pages=768–770|doi=10.1136/bmj.320.7237.768|pmc=1117770|pmid=10720363}}</ref><ref>M. J. Lerner: ''The desire for justice and reactions to victims.'' In: J. McCauley, L. Berkowitz (Hrsg.): ''Altruism and helping behavior''. Academic Press, New York 1970; zitiert nach James Reason: ''Human error: models and management.'' In: ''British Medical Journal.'' 320, Nr. 7237, 18. März 2000, S. 768–770.</ref>。 |

|||

== リファレンス == |

|||

<references />{{stub}} |

|||

[[Category:医療の質]] |

|||

[[Category:科学哲学]] |

|||

[[Category:危機管理]] |

|||

2019年11月17日 (日) 14:18時点における版

スイスチーズモデル(英: Swiss cheese model)は、マンチェスター大学のジェームズ・リーズンが提唱し実証した[1]、航空安全、工学、医療の場などで使われるリスクマネジメントの基礎概念である。

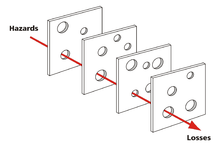

穴の空いているスイスチーズを策に見立て重ねることで貫通するリスクを冗長化している。

複雑なシステムの崩壊への貢献としての潜在的で活発な人為的なエラーの図解表現であり、 事故の原因の連鎖を説明するもの [2] 。

スイスチーズモデルでは、安全性のレベルとチーズスライスを前後に比較。 Emmentalerなどのチーズの穴は、セキュリティシステムの安全性またはセキュリティ 対策の欠陥を反映。 弱点としてのチーズの穴は、予想外にサイズと位置を変える可能性があり、多くの原因因子の好ましくない組み合わせの場合、個々のエラーは損傷 、 事故、または壊滅的な結果に発展。 このモデルでは、チーズの穴が一直線に並び、 弾道の機会が生じる、とすべての安全障壁を克服した理由として述べる [2] [1] 。モデル代わりに、スイスチーズも有用なメタファーとして見ることができる。 [3]

遅延エラーとアクティブエラー

理由は、 スリーマイル島 、 ボパール 、 チャレンジャー 、 キングスクロス 、 チェルノブイリ、 ゼーブルッヘなどの災害からの事故報告を調査し、アクティブな故障と潜在的な故障の区別を示唆している [2]。その後、彼は個人的なシステムエラーのことを話しており [1] 、理由や仮設は ほとんどの事故は組織の影響、監視、前提条件、および具体的な行動の4つの障害領域のうちの1つ以上にまでさかのぼることができると仮定しており、繰延エラーのシステムを有害前に長いされているイベントの管理と組織レベルの前に作成されている危険な行為のことで一緒に不利な状況と個別に、人々の事故につながったとしている(アクティブな失敗)。

アプリケーション

事故原因のスイスチーズモデルはリスク分析とリスク管理に使用されており セキュリティとセキュリティを計画するための出発点で 工学 [3]および医療 鉄道輸送 および航空学など システムセキュリティのため仕事と組織心理学で適用されている [4]。

エラー:人またはシステム

有害なイベントでは、告発は通常、「最前線」の俳優に対するものである( 英語: front line )。 [2] ただし、Reasonによる損害または不幸の考慮は、個人エラーまたはシステムエラーの2つの方法で行うことができる [1]。

事故の原因の理論とモデル

事故の原因を理解するにあたり、Reasonは何年も人々が使用しているアプローチとは区別している。 個人的なアプローチ[5]理論では、主に「忘れっぽさ、不注意、やる気、怠慢、過失、不注意」で、人間の安全でない行為または不作為に考慮される[1][6]。

リファレンス

- ^ a b c d e James Reason (2000-03-18). Human error: models and management. 320. pp. 768–770. doi:10.1136/bmj.320.7237.768. PMC 1117770. PMID 10720363

- ^ a b c d James Reason (1990-04-12). The Contribution of Latent Human Failures to the Breakdown of Complex Systems. 327. pp. 475–484. doi:10.1098/rstb.1990.0090 (JSTOR 55319)

- ^ a b Resilience Engineering: Concepts and Precepts. Ashgate Publishing. (2006). ISBN 978-0-7546-4641-9

- ^ Friedemann W. Nerdinger, Gerhard Blickle, Niclas Schaper (2008). Arbeits- und Organisationspsychologie. Springer. pp. 501f

- ^ Abdul Raouf: Theory of accident causes. In: Jeanne Mager Stellman (Hrsg.): Encyclopaedia of occupational health and safety. 4. Auflage. International Labour Office, Genf 1998, ISBN 92-2-109203-8, Part VIII. Accident prevention, S. 56.6.

- ^ M. J. Lerner: The desire for justice and reactions to victims. In: J. McCauley, L. Berkowitz (Hrsg.): Altruism and helping behavior. Academic Press, New York 1970; zitiert nach James Reason: Human error: models and management. In: British Medical Journal. 320, Nr. 7237, 18. März 2000, S. 768–770.